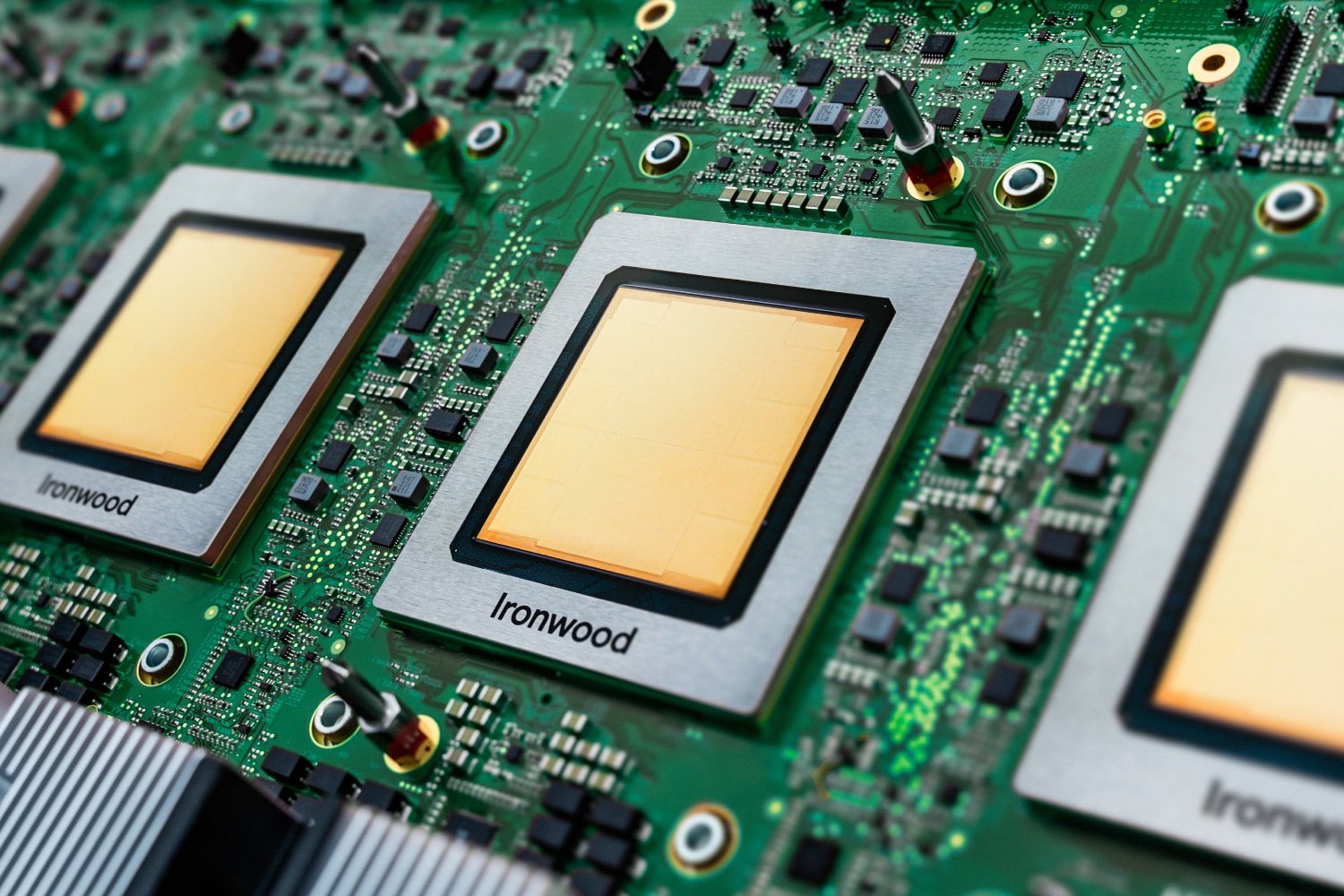

Google a présenté Ironwood, sa toute nouvelle puce maison dédiée à l’intelligence artificielle. Et cette fois, il ne s’agit pas d’un simple coup de polish sur le modèle précédent. Ironwood a été conçue spécifiquement pour l’inférence, c’est-à-dire pour faire tourner les IA après leur entraînement. C’est le moment où le modèle, comme ChatGPT ou Gemini, répond aux questions de l’utilisateur. C’est un type de calcul très exigeant, et Google a clairement décidé d’y aller fort.

Une puce pour faire tourner les modèles d’IA, pas pour les entraîner

Ironwood est la septième génération des TPU (Tensor Processing Unit) de Google. Ces puces ne sont pas vendues à l’unité : elles sont utilisées en interne et mises à disposition des clients via Google Cloud. D’un point de vue technique, Ironwood combine plusieurs nouveautés : chaque puce peut atteindre 4.614 téraflops, et jusqu’à 9.216 puces peuvent être regroupées pour former un « pod » géant. À cette échelle, le système atteint 42,5 exaflops, ce qui dépasse largement les supercalculateurs les plus puissants du moment.

L’architecture de la puce a été repensée pour éviter les goulots d’étranglement. Plus de mémoire (192 Go par puce), plus de débit (7,2 To/s de bande passante), une meilleure communication entre les puces… tout est là pour que les énormes modèles IA puissent tourner sans à-coups. Et malgré cette montée en puissance, Ironwood est deux fois plus économe que Trillium, la génération précédente.

Avec Ironwood, Google s’adresse surtout aux entreprises qui veulent faire tourner des IA complexes dans le cloud. Le groupe met en avant son expérience de dix ans dans le domaine, et le fait que ses propres modèles, comme Gemini ou AlphaFold, tournent déjà sur ces puces.

Google propose aussi un environnement logiciel baptisé Pathways, développé par DeepMind, qui permet de piloter facilement des milliers de puces en parallèle. Il devient ainsi possible d’exécuter des modèles très gourmands sans se prendre la tête avec l’infrastructure. Ironwood intègre même un composant spécialisé, appelé SparseCore, pour accélérer certains types de calculs, par exemple dans les systèmes de recommandation. De quoi intéresser les secteurs de la finance, de la recherche ou du e-commerce.

Pas de vente directe à l’horizon, donc. Mais dans la course à la puissance IA, Google place clairement ses jetons !

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.