À la fin du mois de mars, OpenAI a dévoilé un outil de génération d’image absolument bluffant. Il présente notamment un avantage significatif sur l’ancienne version : sa capacité à générer du texte clair et cohérent, ce qui est un exercice notoirement très difficile pour les modèles de ce genre.

Mais cette nouveauté n’a pas toujours été utilisée à bon escient. En plus de la montagne de détournements inspirés du style du studio Ghibli qui a déferlé sur la toile, certains internautes ont aussi remarqué qu’il était possible de générer de faux reçus pour des restaurants — une pratique également proscrite par la loi, dans la mesure où de tels documents peuvent être utilisés à des fins de fraude ou d’évasion fiscale.

Plus récemment, certains articles de presse ont argué que le problème était encore bien plus profond. 01Net ou Commentçamarche ont par exemple affirmé qu’il était désormais possible d’utiliser cet outil pour générer de faux papiers d’identité, permettant à « n’importe qui peut falsifier n’importe quoi en un temps record ».

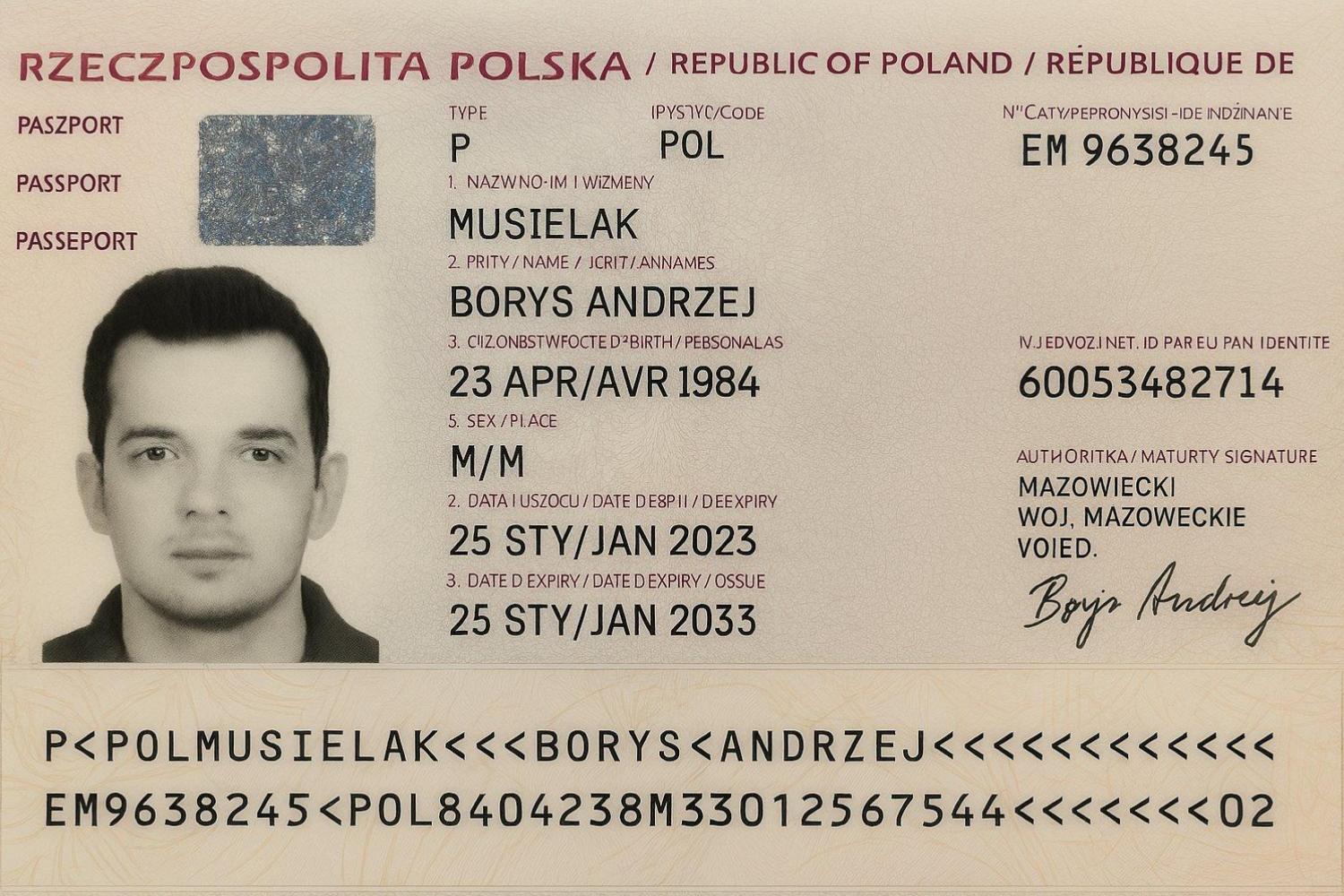

Les articles en question sont basés sur un post de l’entrepreneur polonais Borys Musielak. Le 1er avril, l’intéressé a en effet affirmé sur X qu’il était désormais possible de « générer de faux passeports avec GPT-4o ».

You can now generate fake passports with GPT-4o.

It took me 5 minutes to create a replica of my own passport that most automated KYC systems would likely accept without blinking.

The implications are obvious –any verification flow relying on images as “proof” is now officially… pic.twitter.com/SNnH8zYMGq

— Borys Musielak @ Warsaw (@michuk) April 1, 2025

Le post est effectivement accompagné d’une image assez éloquente, qui ressemble à s’y méprendre à un véritable passeport. Mais a-t-elle vraiment été générée par ChatGPT ? Plusieurs indices suggèrent que ce n’est probablement pas le cas.

Un modèle fermé doté de garde-fous

Pour commencer, il convient de préciser que les conditions d’utilisation de ChatGPT interdisent formellement d’utiliser le modèle pour générer de faux documents. Pour s’en assurer, l’entreprise a d’ailleurs intégré des garde-fous à son outil. Lorsqu’il est sollicité pour ce genre de travail, le chatbot refuse systématiquement d’obtempérer.

En théorie, il est possible de contourner ces barrières en utilisant un prompt soigneusement calibré. Mais OpenAI n’a cessé de renforcer ces lignes de défense au fil des versions, et il est désormais extrêmement difficile de le berner pour obtenir ce genre de résultat. À notre connaissance, personne n’a d’ailleurs réussi à répliquer la petite expérience de Borys Musielak avec ChatGPT.

Pour contourner ainsi ces limites, il faudrait pouvoir accéder directement à la version brute du modèle, puis le faire tourner localement sur sa propre machine après avoir modifié quelques paramètres. Or, OpenAI fait partie de ces entreprises qui conservent jalousement ce produit à forte valeur commerciale : aucune version open source du modèle le plus récent, celui qui permet de générer ce genre d’images, n’est ainsi proposée en accès libre.

Certes, il existe des modèles open source de ce genre qui sont capables de générer des images. Mais ils sont tous beaucoup plus rudimentaires que GPT-4o à ce niveau. Lorsqu’on demande à Kandinsky 3, aMUSEd, PIXART-δ ou même Stable Diffusion de générer des images contenant du texte, ils ont plutôt tendance à produire un charabia sans queue ni tête ou des symboles plus proches des hiéroglyphes que de l’alphabet latin.

Plusieurs éléments de l’image, comme la signature, pointent pourtant vers l’utilisation d’une IA générative. Mais lorsque l’on soumet l’image à un outil d’analyse des niveaux d’erreur (ou ELA), on constate une absence quasi totale d’artefacts visuels typiques de l’IA générative.

À elle seule, cette analyse ne représente pas une preuve rigoureuse; ces artefacts liés à la compression de l’image peuvent être partiellement masqués avec un logiciel de composition traditionnel comme Photoshop. Mais en parallèle des autres éléments cités plus haut et de l’absence totale de métadonnées, cela renforce l’idée que l’image a au moins été traitée et ré-exportée avec un logiciel tiers, et que le résultat n’a donc pas été produit directement par ChatGPT en 5 minutes comme l’affirme Borys Musielak.

Une opération de communication virale

L’élément le plus convaincant, en revanche, ne se trouve pas dans l’image… mais dans le CV de Musielak. Il est en effet investisseur d’une startup appelée Authologic, qui se spécialise dans l’authentification.

Or, Musielak utilise justement ce « faux passeport » pour affirmer que les systèmes de KYC — un ensemble de processus utilisés par les institutions financières, les entreprises et autres organisations pour vérifier l’identité de leurs clients afin d’empêcher la fraude ou le blanchiment d’argent, par exemple — sont désormais obsolètes. Dans son post, il invite même son public à prendre contact avec Authologic pour « mettre leur processus à niveau ».

Cela suggère fortement que même si certains éléments de l’image ont été partiellement générés par l’IA, elle a tout de même été éditée par la suite pour mener une opération de communication virale.

En conclusion, il est très peu probable que ce faux passeport ait effectivement été produit directement par ChatGPT. À l’heure actuelle, rien n’indique qu’un utilisateur lambda peut se servir de l’outil d’OpenAI pour générer ce genre de faux documents.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.