La recherche en intelligence artificielle progresse aujourd’hui à un rythme impressionnant. De plus en plus d’acteurs de l’industrie s’attendent désormais à voir débarquer la première intelligence artificielle générale (IAG), dotée de capacités de raisonnement supérieures à celles des humains, d’ici quelques années. Une perspective aussi enthousiasmante que préoccupante, et pour cause : des experts estiment depuis longtemps qu’un tel système pourrait semer une zizanie sans précédent dans notre civilisation.

C’est une thématique qui a souvent été explorée par les auteurs de fiction dans des œuvres comme 2001 : l’Odyssée de l’Espace, Terminator, ou encore Matrix pour ne citer qu’elles. Mais aussi percutants soient-ils, ces scénarios restent évidemment assez caricaturaux.

Si une intelligence artificielle très avancée se met un jour à causer du tort à l’humanité, elle pourrait aussi le faire de manière plus subtile et moins extrême. Pour éviter une éventuelle catastrophe, il convient d’établir dès à présent un ensemble de lignes directrices solides. Et c’est précisément l’objet du dernier papier technique de DeepMind, repéré par Ars Technica.

Pour ceux qui n’en sont pas familiers, cette succursale de Google est l’une des entreprises les plus avancées de l’industrie. De la théorie des jeux (AlphaZero, AlphaGo…) à la biologie structurale (AlphaFold) en passant par les prévisions météorologiques (GenCast) ou la fusion nucléaire, elle a développé de nombreux systèmes basés sur l’IA pour s’attaquer à des problèmes qui semblaient autrefois totalement inabordables.

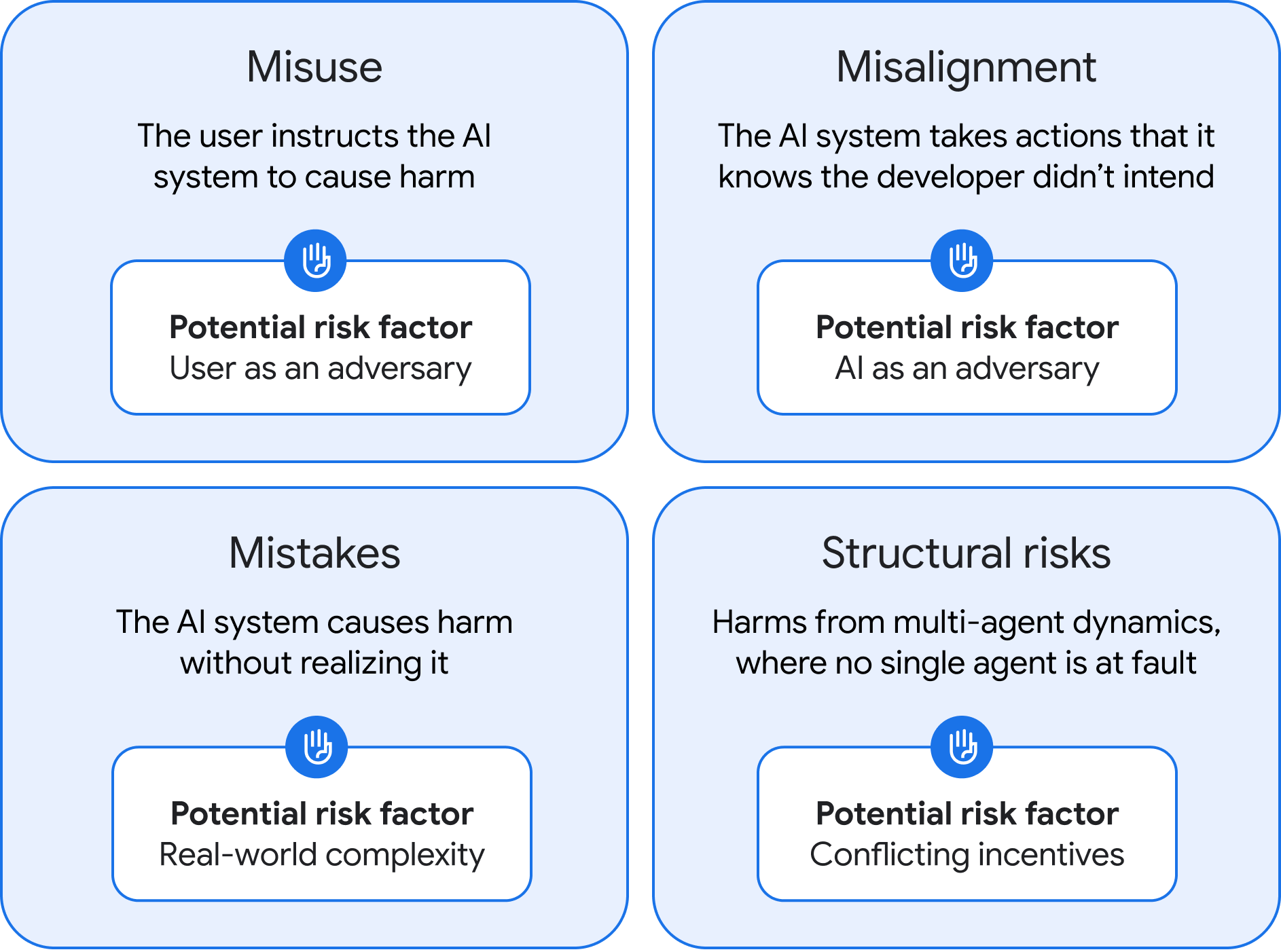

Récemment, ses chercheurs ont publié un long papier qui explore différentes approches pour limiter les risques associés au développement d’une IAG. Il se focalise notamment sur les différents types de risques associés à un tel système. Au total, les auteurs ont identifié quatre grandes catégories.

Une arme pour les humains mal intentionnés

La première concerne ce que DeepMind décrit comme des « abus ». Dans ce cas, ce n’est pas le système lui-même qui pose directement problème, mais les humains qui le pilotent. Il semble en effet évident qu’un outil aussi puissant qu’une IAG pourrait provoquer de gros dégâts s’il tombait entre les mains d’acteurs mal intentionnés. Ces derniers pourraient par exemple lui demander d’exploiter des vulnérabilités critiques de cybersécurité, notamment au niveau d’infrastructures critiques comme des centrales nucléaires, de créer de redoutables armes bactériologiques, et ainsi de suite.

DeepMind estime donc que les entreprises doivent impérativement mettre en place des protocoles de validation et de sécurité extrêmement solides, et ce dès à présent. Les auteurs insistent également sur l’importance de développer des techniques qui permettent de forcer les modèles IA à « oublier » des données, afin de pouvoir leur couper l’herbe sous le pied en urgence si un scénario catastrophe commence à pointer le bout de son nez.

Les erreurs d’alignement

La deuxième catégorie rassemble tous les problèmes liés à ce qu’on appelle l’alignement — le fait de s’assurer que ces modèles IA “comprennent” les valeurs et les attentes des humains, et leur donnent la priorité au moment d’agir. Un système mal aligné, en revanche, pourrait donc entreprendre des actions dont il sait pertinemment qu’elles ne correspondent pas à la vision de leur créateur.

C’est le cas de figure qui revient le plus souvent dans la fiction. Par exemple, si HAL 9000 tente d’éliminer l’équipage du vaisseau dans 2001 : l’Odyssée de l’Espace, c’est parce qu’il considère que le succès de la mission a plus de valeur que la vie humaine. Même constat pour Skynet dans la saga Terminator : alors qu’il était initialement conçu pour défendre l’humanité, il a finalement conclu qu’il s’agissait d’une menace qui méritait d’être éradiquée à tout prix.

Pour éviter ce genre de scénario, DeepMind propose une première solution intéressante : faire travailler les IAG en binôme. Au lieu d’évoluer seules, elles seraient constamment supervisées par un clone strictement identique, réduisant ainsi les risques de dérive. Mais les auteurs du papier reconnaissent que cette approche serait sans doute loin d’être infaillible.

En parallèle, ils recommandent donc de faire tourner les futures IAG dans des “bacs à sable virtuels”. Ce terme désigne des espaces numériques isolés du reste du système, qui sont aujourd’hui surtout utilisés dans le domaine de la cybersécurité pour tester des programmes sensibles sans risquer de compromettre le reste de l’infrastructure. En théorie, si un problème survient, il suffit donc de désactiver cette sandbox pour priver l’IAG de sa capacité à nuire. On peut toutefois se demander si un système aussi rusé ne pourrait pas trouver un moyen de s’en échapper…

Quand l’IA perd les pédales

La troisième catégorie, intitulée “Erreurs”, peut sembler assez similaire aux problèmes d’alignement. Mais elle repose toutefois sur une distinction cruciale : ici, le modèle IA n’a pas conscience des conséquences néfastes de ses actions. Il pense bien faire alors qu’il est complètement à côté de la plaque, comme quand la fonctionnalité AI Overview de Google a recommandé à des internautes de mettre de la colle sur leurs pizzas pour empêcher le fromage fondu de glisser.

Cet exemple prête à sourire, mais on peut aisément imaginer des situations où de telles erreurs (parfois appelées hallucinations) pourraient avoir des conséquences terribles. Imaginez par exemple qu’une IAG à vocation militaire pense détecter les signes avant-coureurs d’une frappe nucléaire ; elle pourrait alors déclencher des “représailles” totalement injustifiées, conduisant à l’annihilation totale d’une partie du globe sur la base d’une simple erreur.

La mauvaise nouvelle, c’est qu’il n’existe pas vraiment d’approche généralisée pour limiter ces erreurs. Pour les auteurs du papier, il sera donc crucial de déployer les futures IAG progressivement, avec des tests rigoureux à chaque étape, et surtout de limiter leur capacité à agir de manière autonome.

Des risques structuraux à grande échelle

La dernière catégorie, et peut-être la plus intéressante, rassemble ce que DeepMind appelle des “risques structuraux”. Ici, le problème n’émergerait pas d’un seul système isolé, mais des interactions entre plusieurs systèmes complexes intégrés à différents niveaux de notre société.

Ensemble, ces systèmes interactifs pourraient “accumuler un contrôle de plus en plus important sur nos systèmes économiques et politiques”, sur la circulation des informations, et ainsi de suite. En d’autres termes, l’IAG finirait par prendre le contrôle de notre société tout entière, pendant que les humains ne seraient plus que des pions organiques insignifiants sur un vaste échiquier virtuel. Un scénario dystopique qui fait décidément froid dans le dos.

Les chercheurs soulignent que cette catégorie de risque sera sans doute la plus difficile à contrer, car les conséquences potentielles dépendent directement de la manière dont les personnes, les infrastructures et les institutions fonctionnent et interagissent.

À l’heure actuelle, personne ne sait exactement quand — ou même si — une véritable IAG finira effectivement par émerger. Mais dans le contexte actuel, il serait bien imprudent de ne pas prendre cette éventualité au sérieux. Il sera donc intéressant de voir si OpenAI et consorts baseront leurs futurs travaux sur ce papier certes abstrait, mais néanmoins très intéressant.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.