Le développement intellectuel des enfants, et tout particulièrement leur apprentissage du langage, est un sujet qui fascine les chercheurs depuis des siècles. Récemment, une équipe américaine a utilisé une méthode assez originale pour étudier ces mécanismes : ils ont créé un modèle IA qui imite la manière dont les bambins apprennent leurs premiers mots. Une approche qui pourrait représenter une nouvelle fenêtre sur le développement des facultés cognitives.

Pour arriver à ce résultat, les auteurs de l’étude n’ont pas utilisé un grand modèle de langage (LLM), comme ceux qui alimentent les chatbots de type ChatGPT. Pour s’approprier les nuances du langage humain, ces derniers digèrent d’énormes quantités de texte; ce sont des dizaines milliards de mots qui leur servent de référence. Une approche difficilement applicable à notre espèce, puisque les jeunes humains sont bien incapables de gérer autant d’informations.

“Un enfant n’exploite pas la totalité d’Internet comme le font certains de ces LLM”, explique Wai Keen Vong, chercheur à l’Université de New York interviewé par ScienceNews. À la place, ils se reposent majoritairement sur le langage de leurs parents. Il s’agit d’un ensemble de données beaucoup plus restreint. Les chercheurs se sont donc demandé si un modèle IA serait capable d’apprendre les rudiments du langage dans les mêmes conditions.

Un mini-modèle IA pour imiter les jeunes enfants

Pour vérifier cette hypothèse, ils ont intentionnellement construit un modèle de langage beaucoup plus modeste que ChatGPT et consorts, et donc plus réaliste du point de vue humain.

À partir de là, ils ont dû sélectionner les données qui allaient servir à entraîner ce modèle. Au lieu de jouer aux devinettes, ils ont choisi de se baser sur l’expérience du sujet le plus pertinent qui soit : Sam, un vrai bébé en chair et en os né en Australie. Entre ses six mois et ses deux ans, ses parents l’ont régulièrement équipé d’une petite caméra frontale. Les chercheurs ont ainsi pu se placer dans la peau de l’enfant pour déterminer exactement à quels objets et mots il a été confronté durant cette période charnière de la vie.

Le programme des chercheurs a épluché environ 60 heures d’enregistrement pour essayer de construire des relations entre les images et mots prononcés par les parents de Sam. Au fil du temps, le modèle a appris à faire correspondre différents sons à des objets, exactement comme le font les vrais bébés.

Des performances comparables à celles d’un vrai bébé

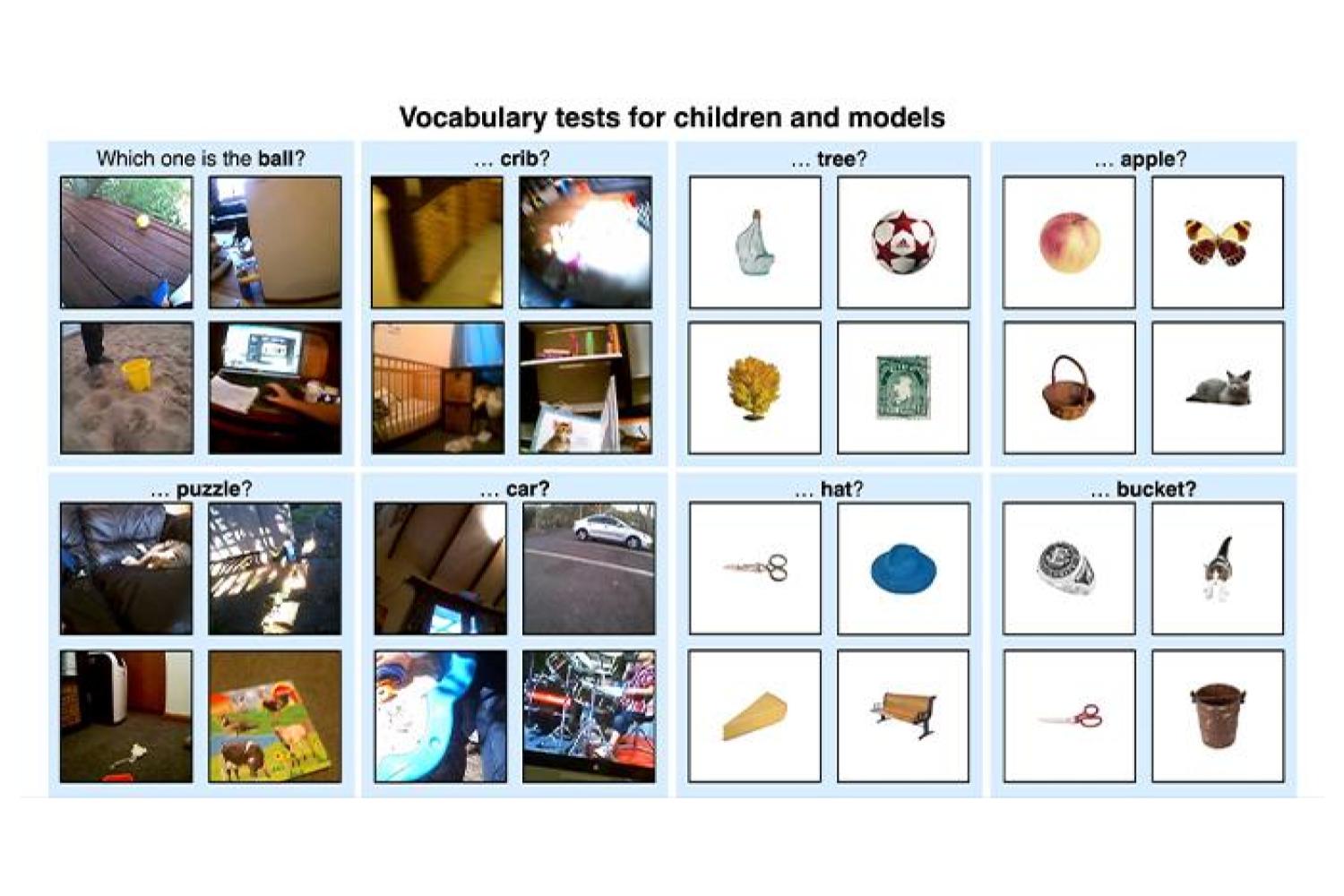

Pour vérifier si leur algorithme avait été bon élève, ils l’ont soumis à une série d’exercices conçus spécialement pour l’apprentissage du langage chez les petits humains. Ils lui ont proposé des ensembles de quatre images en lui demandant de désigner celle qui correspond à un mot précis.

À la fin de son entraînement, le modèle a trouvé la bonne réponse dans 62% des cas. C’est un score nettement supérieur à celui qu’on obtiendrait en répondant systématiquement au hasard (25%). En fait, les performances du modèle correspondaient à peu près à ce qu’on attend d’un enfant d’un à deux ans dans ces conditions.

Au niveau purement algorithmique, il s’agit d’un très beau succès. Cette expérience montre qu’il est techniquement possible d’entraîner un modèle de langage à partir d’un ensemble de données extrêmement restreint, à des années-lumière des ressources dont disposent les LLM comme GPT 4.

“Ce qu’ils ont prouvé, c’est que si on peut faire le lien entre les sons qu’on entend et le contexte, alors on peut démarrer le processus d’apprentissage des mots”, explique Evan Kidd, un psycholinguiste australien non affilié à l’étude.

Une vraie piste de recherche en neuropsychologie

Au-delà de la recherche en IA, ces travaux sont aussi très intéressants au niveau de la neurologie et du développement. Il convient cependant d’être prudent par rapport à l’interprétation et d’éviter les raccourcis logiques. Cette expérience ne suffit pas à prouver que le processus d’apprentissage des enfants est comparable au fonctionnement de ce programme. Mais il s’agit tout de même d’une vraie possibilité qui mérite d’être explorée. Car si cette hypothèse était confirmée, ces algorithmes pourraient devenir d’excellents modèles pour étudier le développement intellectuel au cours des premières années de la vie.

Pour aller plus loin, Kidd estime qu’il serait très intéressant de comparer les erreurs les plus courantes chez les bébés à celles du modèle IA. On sait notamment que les très jeunes enfants ont parfois tendance à généraliser certains concepts, par exemple en appelant tous les hommes adultes “papa”. Si l’IA fait le même genre d’erreurs, il s’agira d’un signe très encourageant que les chercheurs sont sur la bonne piste.

Ce processus de comparaison pourrait permettre d’identifier certaines des limites qui empêchent encore ces modèles IA de rivaliser avec le cerveau humain. Vong est particulièrement curieux par rapport à la façon dont l’algorithme va apprendre la signification des verbes, qui sont généralement bien plus abstraits que les noms d’objets. Prenez le mot “courir”, par exemple; un bébé pourrait s’approprier cette notion en essayant de reproduire les mouvements de ses semblables. Mais ce sera une autre paire de manches pour un algorithme dénué de corps physique. “Du point de vue de la caméra, ça ressemblerait juste à des secousses”, explique Vong.

Il sera donc assez fascinant d’observer la suite de ces travaux, ainsi que toutes les expériences comparables qui utilisent ces réseaux de neurones artificiels pour explorer la complexité du cerveau humain.

Le texte de l’étude est disponible ici.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.