Pour la première fois, des chercheurs ont présenté un système non invasif qui permet de traduire les pensées d’une personne en texte sans avoir recours à un implant ou à des équipements lourds et encombrants.

Même si cela relevait encore de la science-fiction pure et simple il y a peu, la recherche sur la lecture des pensées a fait d’immenses progrès en l’espace de quelques années. Ces travaux se basent sur l’analyse de différents paramètres physiologiques au niveau du cerveau, qui sont ensuite transcrits à l’aide de différents systèmes annexes.

Par exemple, certaines approches reposent sur l’enregistrement des ondes cérébrales, des impulsions électriques qui parcourent le cerveau. Il est possible de les capturer à l’aide de ce qu’on appelle un électroencéphalogramme (EEG) pour étudier les variations de fréquence qui sont associées à différents types d’activité cérébrale.

Certains chercheurs ont aussi eu recours à des techniques comme l’IRMf, pour imagerie par résonance magnétique fonctionnelle. Cela consiste à observer le flux sanguin dans les diverses régions du cerveau, qui est directement corrélé à l’activation des neurones concernés. En d’autres termes, en observant où se dirige le sang, on peut en déduire quels processus cognitifs sont en train de se dérouler.

Une niche technologique prometteuse mais jonchée d’obstacles

Ces deux approches ont déjà produit de beaux résultats, mais elles présentent aussi des inconvénients rédhibitoires. Par exemple, il est typiquement impossible de traduire un électroencéphalogramme standard en texte ; pour y parvenir, les chercheurs s’appuient généralement sur des implants posés à même le cerveau, avec tous les problèmes associés à la chirurgie invasive. Les méthodes basées sur l’IRM ne souffrent pas de ces problèmes ; en revanche, elles nécessitent d’avoir accès à du matériel lourd, encombrant et très cher, ce qui est tout sauf idéal.

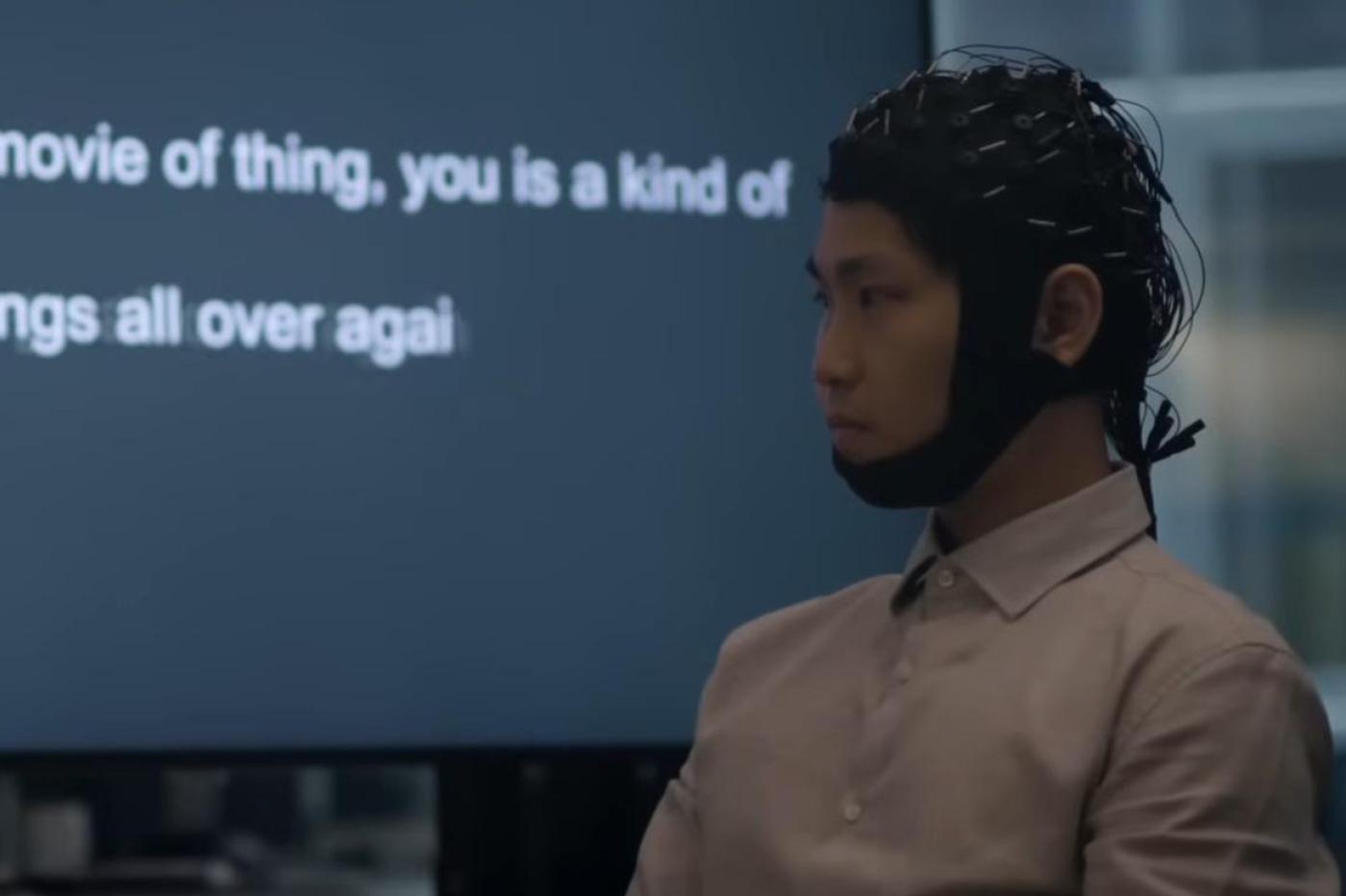

Les chercheurs australiens à l’origine de ces travaux repérés par ScienceAlert sont parvenus à leurs fins avec du matériel beaucoup plus pratique. Leur technologie, baptisée DeWave, repose essentiellement sur une sorte de bonnet truffé d’électrodes qui enregistrent les ondes cérébrales du patient en continu, comme un système EEG classique.

Jusqu’à présent, les chercheurs ont eu énormément de mal à traduire ces EEG bruts en texte. En effet, au niveau neurologique, la structure du langage est très différente de celle d’un texte écrit. De plus, des mots relativement proches au niveau sémantique peuvent produire des ondes cérébrales quasiment identiques en fonction du contexte. Il est donc très difficile d’établir des liens précis. Pour y parvenir, les études précédentes ont souvent fait intervenir des systèmes de tracking des yeux pour aider leurs programmes à interpréter les ondes cérébrales.

Le premier système “brain-to-text” portable et non-invasif

Pour la première fois, les auteurs de cette nouvelle étude ont réussi à surmonter (partiellement) ces limites en utilisant un assortiment de systèmes de machine learning. Ils ont conçu un algorithme capable de transformer les EEG bruts en une sorte de code intermédiaire. À partir de là, chaque portion de code peut être associée à des mots spécifiques, et un modèle de langage (en l’occurrence GPT) se charge ensuite de reconstituer des phrases complètes.

En termes de résultats, les progrès sont encore assez timides. Selon les chercheurs, DeWave affiche une précision d’environ 40 %. Assez pour avoir une vague idée des propos de la personne, mais largement insuffisant pour retranscrire toutes les nuances d’une conversation.

Mais il ne s’agit que d’une preuve de concept. Au-delà de la précision brute, il s’agit quand même d’un vrai progrès, car cela prouve la viabilité de cette approche qui produira sans doute de bien meilleurs résultats une fois qu’elle sera mature. L’objectif des chercheurs est d’atteindre une précision d’environ 90 %, ce qui serait comparable aux performances des systèmes speech-to-text traditionnels.

« C’est une première de pouvoir incorporer ces techniques d’encodage discrètes dans le processus de traduction “cerveau-à-texte” » explique Chin-Teng Lin, chercheur à l’ (UTS) et auteur principal de l’étude. « Cela représente une nouvelle approche innovante du décodage neuronal », se réjouit-il.

L’autre intérêt de cette manière de procéder, c’est que les systèmes comme DeWave bénéficieront grandement des progrès rapides des grands modèles de langage modernes. D’ici quelques années, nous pourrions donc voir émerger les premiers systèmes de transcription grand public portables et non invasifs basés sur GPT et consorts. De quoi améliorer massivement la qualité de vie des personnes qui sont physiquement incapables de s’exprimer à cause d’une grave pathologie, comme la maladie de Charcot, ou d’un traumatisme physique sévère.

Le texte de l’étude est disponible ici.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.

On utilise l’excuse “améliorer la qualité de vie de gens qui souffrent de telle maladie” pour développer un device qui à terme pourrait avoir des applications qui vont bien au-delà. En cinq minutes, j’en ai déjà au moins trois dans qui me viennent dans le domaine militaire, deux dans le domaine du divertissement, une dans le domaine de la sécurité intérieure et évidemment une dans celui des télécom/communication en général. Bref, désolé pour ceux qui sont atteints de maladies ou pathologies qui les empêches de s’exprimer, mais il y a un sacré souci d’éthique derrière ce programme de recherche. Ça ressemble quand même à un joli cheval de Troie pour accéder à une des seules choses qui nous appartient encore un peu… nos pensées. Ça promet.