DeepMind, l’entreprise satellite de Google spécialisée dans l’IA, a récemment présenté FunSearch, une méthode qui permet de chercher de nouvelles solutions à des problèmes mathématiques et algorithmiques complexes en s’appuyant sur un LLM (un grand modèle de langage de la même famille que GPT).

Le but du LLM en question est de fournir des solutions créatives sous forme de code informatique. Pour qu’il puisse y parvenir, les chercheurs y ont ajouté un deuxième modèle IA complémentaire, baptisé « évaluateur ». Comme son nom l’indique, son objectif est d’évaluer les idées proposées. Cela permet à la fois de conserver les idées les plus prometteuses et d’exclure les approches incorrectes.

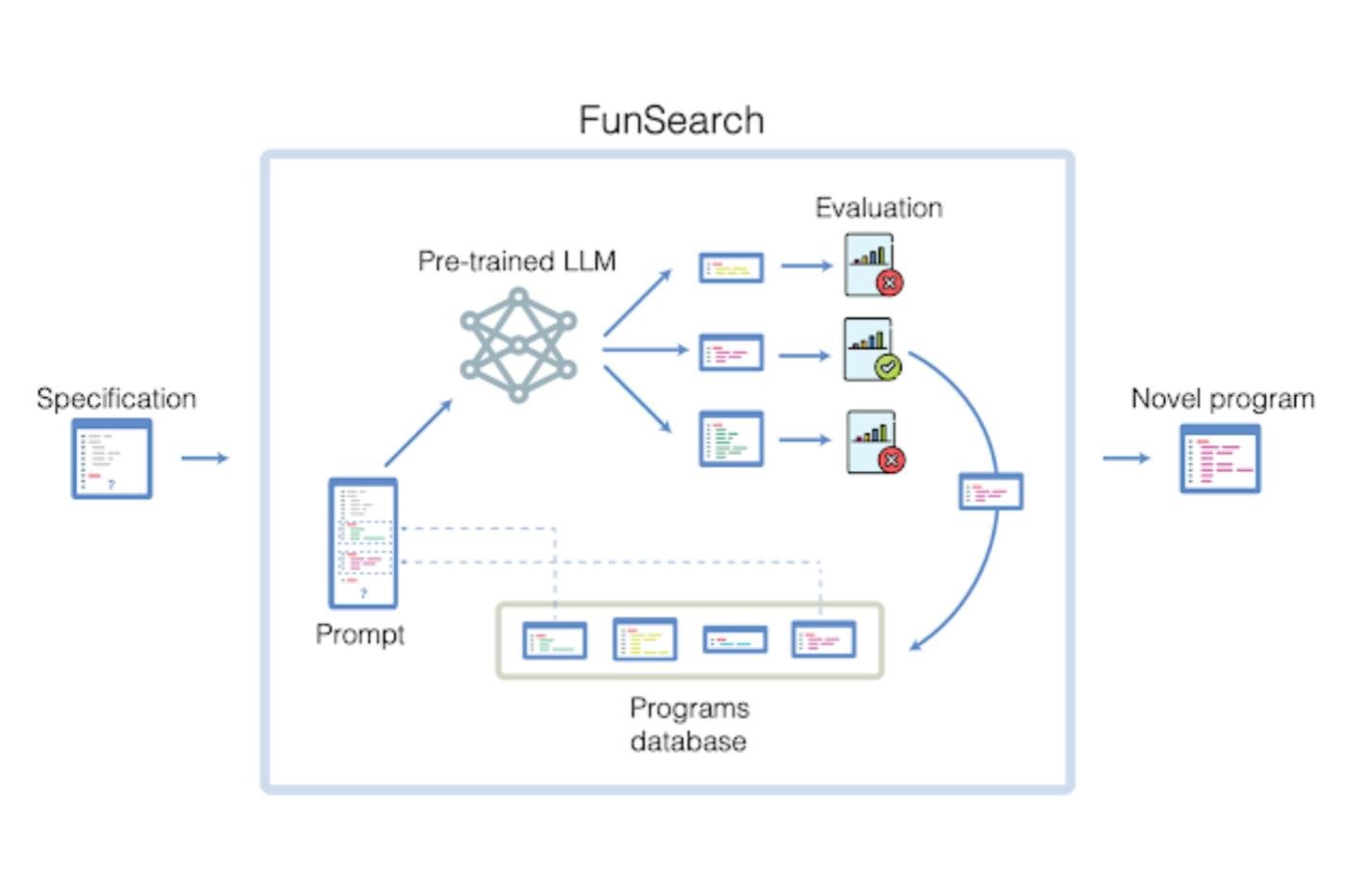

Le fonctionnement de FunSearch (pour FunctionSearch) repose sur une sorte de jeu de ping-pong entre ces deux composants. À chaque itération, le LLM sélectionne différents programmes dans une base de données. Il essaie de générer de nouvelles solutions créatives en extrapolant sur la base des concepts utilisés dans ces programmes. Il les envoie ensuite à l’évaluateur, qui conserve les nouveaux programmes les plus à même de résoudre le problème visé. Ces derniers sont alors réinjectés dans la base de données afin que le LLM puisse continuer à travailler dessus.

Cela crée une boucle d’autoamélioration perpétuelle qui fonctionne un peu comme le processus d’évolution. L’évaluateur peut être assimilé à une pression de sélection. Il force le système à identifier les éléments les plus critiques pour avancer sur un problème donné tout en améliorant progressivement la diversité des idées afin d’éviter la stagnation.

Des progrès concrets sur deux énigmes algorithmiques tenaces

Cette approche basée sur l’auto-renforcement continuel n’est pas entièrement nouvelle. DeepMind y a déjà eu recours avec GNoME, un modèle IA consacré à la recherche de nouveaux cristaux.

En revanche, c’est la première fois qu’elle est appliquée à des problèmes d’ordre mathématique ou algorithmique. Et cette façon de procéder a déjà produit de beaux résultats.

Pour commencer, FunSearch a trouvé une solution au problème du cap set. Imaginez un ensemble de vecteurs, que l’on peut assimiler à des flèches qui ont chacun une direction et une longueur bien précises. Dans le problème du cap set, chacun des vecteurs présents dans un espace doit respecter certaines règles. Premièrement, on ne peut les combiner qu’en les additionnant, ce qui revient à tracer un chemin en mettant ces flèches bout à bout. Deuxièmement, il est interdit d’avoir trois vecteurs dont la somme est zéro ; en d’autres termes, il est interdit de tracer une suite de trois flèches qui revient à son point de départ.

L’objectif du problème est de trouver la plus longue suite possible de vecteurs qui respectent ces règles. Cette explication tortueuse peut sembler horriblement abstraite (et elle l’est). Mais cette énigme mathématique a des implications très concrètes, notamment dans la science du chiffrement et la programmation. Malheureusement, elle n’a été que partiellement résolue.

En effet, la complexité du problème est relativement abordable lorsqu’on raisonne en deux ou trois dimensions. Mais lorsqu’on extrapole à des dimensions plus élevées, elle augmente de façon exponentielle. Très vite, on se retrouve avec un nombre de possibilités supérieur au nombre d’atomes dans l’univers, bien au-delà des capacités des meilleurs supercalculateurs. De plus, les travaux dans des espaces à plus de trois dimensions sont souvent beaucoup trop abstraits et contre-intuitifs pour le cerveau humain.

Puisque ni l’intuition humaine ni la force brute des supercalculateurs ne fonctionne, on se retrouve donc dans un cul-de-sac. Le problème du cap set n’a toujours pas de solution dans un espace à plus de quatre dimensions.

Ou du moins, c’était le cas jusqu’à l’intervention de FunSearch. Il n’a pas réussi à trouver une solution générale qui fonctionne dans n’importe quelle dimension, mais il a tout de même repoussé les limites du problème à un niveau de complexité que l’on pensait autrefois complètement inatteignable, même pour les supercalculateurs d’élite. Ces solutions sont décrites dans un papier de recherche publié dans la prestigieuse revue Nature.

Encouragés par ce succès, les chercheurs ont aussi soumis un autre exercice à FunSearch : le problème du bin packing, qui consiste à ranger un maximum d’objets dans un nombre minimum d’espaces différents (ou « boîtes »). Là encore, c’est une énigme qui peut aider à résoudre de nombreux problèmes concrets. Certains sont d’ordre logistique, comme le remplissage optimal de containers. D’autres sont plutôt informatiques, comme l’organisation des fichiers sur un support de stockage.

Comme avec le cap set, FunSearch n’a pas trouvé de solution générale ; mais il a fait émerger de nouveaux algorithmes très efficients qui pourraient avoir des tas d’applications très utiles dans l’industrie.

Ces résultats montrent que la technique évolutive de FunSearch peut repousser les limites de certains problèmes algorithmiques extrêmement épineux. C’est donc une approche prometteuse, et les chercheurs s’ attendent à ce qu’elle joue un rôle central dans de nouvelles découvertes importantes sur d’autres problèmes mathématiques et algorithmiques aux implications très concrètes.

La fin de la « boîte noire » de l’IA ?

Mais l’intérêt de FunSearch ne s’arrête pas à ces belles promesses. Le système dispose d’un autre avantage exceptionnellement intéressant, car quasiment inédit dans le domaine du machine learning. Le gros problème de cette discipline, c’est que les modèles IA modernes sont des sortes de boîtes noires. On sait quelles données on fournit à l’entrée, on obtient un résultat à la sortie, mais tout le processus qui se déroule entre les deux est beaucoup trop abstrait pour être compréhensible par le cerveau humain.

Mais ce problème n’existe pas avec le nouveau système de DeepMind. Au lieu de générer des solutions fonctionnelles mais obscures, son approche évolutive lui permet de décrire exactement comment il est parvenu à telle ou telle solution.

Plus spécifiquement, il est conçu pour générer des programmes clairs et compacts ; pour référence, on dit qu’ils présentent une faible complexité de Kolmogorov. C’est très important, car cela signifie que ses productions sont beaucoup plus abordables pour les humains, et que ces derniers peuvent en tirer des leçons exploitables.

« FunSearch offre un tout nouveau mécanisme pour développer des stratégies de résolution », explique Jordan Ellenberg, professeur de mathématiques à l’Université du Wisconsin qui a collaboré avec DeepMind sur ce projet. « Les solutions qu’il génère sont conceptuellement beaucoup plus riches que de simples suites de nombres. Quand je les étudie, j’apprends quelque chose », indique-t-il dans le communiqué de la firme.

Les chercheurs peuvent donc y voir beaucoup plus clair qu’avec les modèles IA traditionnels. Ils peuvent donc manipuler les résultats plus facilement et améliorer le système de manière efficace, au lieu d’avancer à tâtons en espérant que l’algorithme avancera dans la direction souhaitée.

Les modèles IA, de nouveaux partenaires de recherche

En conclusion, FunSearch représente un énorme pas en avant. C’est la première fois qu’un système à base de machine learning aide ainsi les humains à trouver des solutions originales à des problèmes concrets, et qu’il le fait en suivant une méthodologie claire et compréhensible pour les chercheurs.

Rien ne dit que cette approche sera pertinente pour tous les problèmes que l’humanité cherche à résoudre grâce à l’IA. Mais tout indique que nous nous approchons désormais d’un futur où les réseaux de neurones artificiels pourront devenir des sources d’inspiration exceptionnelles plus seulement pour les artistes, mais aussi pour les scientifiques et les théoriciens.

« Le plus excitant pour moi, c’est qu’on peut désormais modéliser de nouveaux modes de collaboration entre les humains et les machines », résume Ellenberg dans Nature. «Je ne compte pas utiliser ces modèles pour remplacer les mathématiciens humains, mais m’en servir pour multiplier leur capacité à résoudre des problèmes ».

Le texte de l’étude est disponible ici.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.