Stanford fait partie de ces institutions qui consacrent des ressources conséquentes à l’étude de ChatGPT, le chatbot alimenté au machine learning d’OpenAI. Une équipe de chercheurs de la prestigieuse université américaine a récemment publié une nouvelle étude où elle a comparé les performances du programme à celles de ses étudiants.

C’est une approche qui a le vent en poupe, car il s’agit d’une bonne façon d’estimer la capacité du programme à apporter des contributions très concrètes à l’humanité. Par exemple, plusieurs laboratoires de recherche ont déjà exploré les capacités de ChatGPT dans des examens de gestion ou encore de droit, avec des résultats certes hétérogènes mais souvent impressionnants.

Cette fois, l’équipe du chercheur et médecin hospitalier Eric Strong a voulu vérifier de quoi il était capable par rapport à aux étudiants de première et deuxième année de médecine à Stanford. C’est un cursus de haut niveau que tous les classements nationaux placent au moins parmi les sept meilleurs du pays.

Des QCM aux questions ouvertes

La particularité de cette étude, c’est qu’elle s’est concentrée sur les études de cas, qui ne comportaient que des questions ouvertes. Ces tests qui offrent une grande latitude aux candidats sont nettement plus difficiles que celles à choix multiples.

Avec ces dernières, le chatbot peut simplement décortiquer les différentes réponses possibles pour deviner celle qui est correcte. Une question ouverte, en revanche, implique de comprendre chaque nuance d’un énoncé complexe. Et surtout, il faut ensuite formuler une réponse argumentée et cohérente. C’est un exercice beaucoup plus intimidant, aussi bien pour les étudiants que pour les systèmes à base de machine learning.

Les auteurs du texte ont compilé 14 études de cas différentes. Les énoncés contenaient de quelques centaines à un millier de mots. Ils étaient aussi truffés de détails piégeux sur diverses maladies chroniques ou traitements qui n’étaient pas forcément importants pour la résolution du problème. C’est une façon de forcer les candidats à filtrer les éléments pertinents dans le cadre du diagnostic.

Ils ont soumis ces études de cas à des étudiants de première et deuxième année sélectionnés aléatoirement, puis à la dernière version de ChatGPT basée sur GPT-4. Les copies ont ensuite été notées à l’aveugle par un panel d’enseignants expérimentés.

Davantage de réponses passables et un score moyen plus élevé

En moyenne, les candidats humains ont obtenu des notes suffisantes pour passer l’examen sur 85 % de ces études de cas. Le chatbot, de son côté, a réussi à faire mieux ; ses réponses ont convaincu les examinateurs dans 93 % des cas. Et il ne s’agissait pas seulement de proposer davantage de réponses tout juste passables. En moyenne, ChatGPT a scoré 4,2 points de plus que les apprentis médecins en chair et en os.

Ce score impressionnant ne signifie en aucun cas que le chatbot est désormais prêt à remplacer un praticien professionnel, loin de là. En revanche, cela suggère qu’il devient de plus en plus performant dans sa façon d’aborder ces cas épineux.

Quelle place pour l’IA dans la médecine ?

Ces conclusions renforcent l’idée que certains étudiants pourraient être tentés d’utiliser le chatbot pour tricher. C’est une thématique qui devient de plus en plus importante pour les éducateurs, comme en témoigne l’affaire de triche qui a frappé l’Université de Lyon en début d’année.

Conscients de cet écueil potentiel, les responsables de la Stanford School of Medicine ont pris la décision de changer radicalement les modalités de leurs examens.

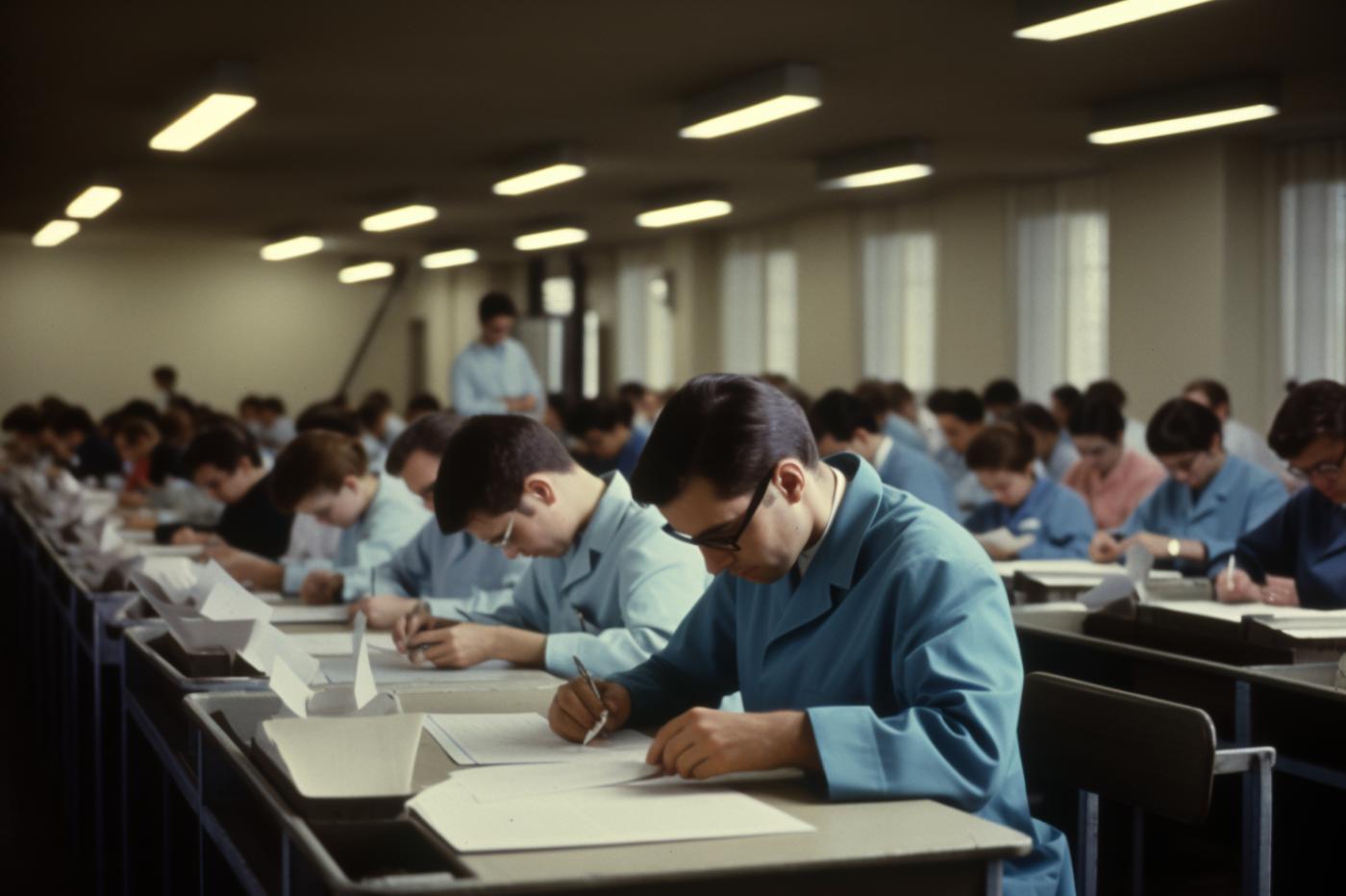

Jusqu’à présent, les étudiants pouvaient s’appuyer sur des ressources académiques tirées du web pour répondre à ces questions. Mais au semestre dernier, l’administration a choisi de passer à un modèle fermé à l’ancienne. Les étudiants doivent désormais raisonner uniquement sur la base des informations qu’ils ont mémorisées pendant l’année.

Cela permet effectivement de réduire le nombre de cas de triche – mais il y a un revers de la médaille. Cela empêche les examinateurs de tester la capacité des candidats à identifier et à exploiter des sources fiables pour prendre une décision éclairée — une compétence fondamentale dans l’exercice des professions médicales.

Pour cette raison, Stanford travaille en ce moment sur une nouvelle mise à jour du cursus. Ils envisagent d’intégrer explicitement des outils basés sur l’IA aux pratiques d’enseignement. L’objectif revendiqué est de mieux préparer les étudiants, au lieu de les couper d’un outil qui prendra vraisemblablement une place de plus en plus importante dans la médecine de demain.

« Nous ne voulons pas former des médecins qui sont tellement dépendants de l’IA qu’ils ne pourront même plus apprendre à raisonner par eux-mêmes », explique Alicia DiGiammarino, responsable de la deuxième année de médecine à Stanford et co-autrice de l’étude.

« Mais j’ai encore plus peur d’un monde où les médecins ne seront pas entraînés à utiliser correctement l’IA. Nous sommes encore très loin de remplacer entièrement les médecins, mais il ne nous reste probablement que quelques années avant que l’IA soit incorporée à la médecine du quotidien », conclut-elle.

Le texte de l’étude est disponible ici.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.

Merci de m’avoir appris le mot “piégeux”, car j’aurais dit “des détails piégeant”, mais c’est effectivement un mot du dictionnaire.

La subtilité du français dépasse la mienne… ;-(

Pareil pour votre titre “surclasse les étudiants” : je lui donnais un sens à l’opposé, mais en regardant dans le dictionnaire vous l’utilisez correctement et donc j’apprends encore.

Décidément ça fait du bien de pouvoir lire des articles qui permettent d’enrichir son français au lieu de l’appauvrir voir de le détruire comme sur beaucoup de sites.

Donc bravo à vous et merci !

N’oublions pas de vous remercier aussi pour le contenu de l’article, très intéressant.