À force d’entendre parler d’algorithmes à tort et à travers ces derniers temps, on pourrait presque oublier que la course à l’intelligence artificielle ne se joue pas seulement du côté logiciel. Pour entraîner d’énormes modèles comme ChatGPT, il faut aussi avoir accès à une puissance de calcul phénoménale, ce qui implique d’avoir accès à du hardware de première catégorie. Aujourd’hui, c’est Nvidia qui domine ce segment de la tête et des épaules… mais Google attend en embuscade.

Si le géant vert est aussi bien implanté dans le domaine de l’informatique haute performance (HPC), c’est parce qu’elle propose de nombreux composants très haut de gamme qui font office de référence sur ce segment.

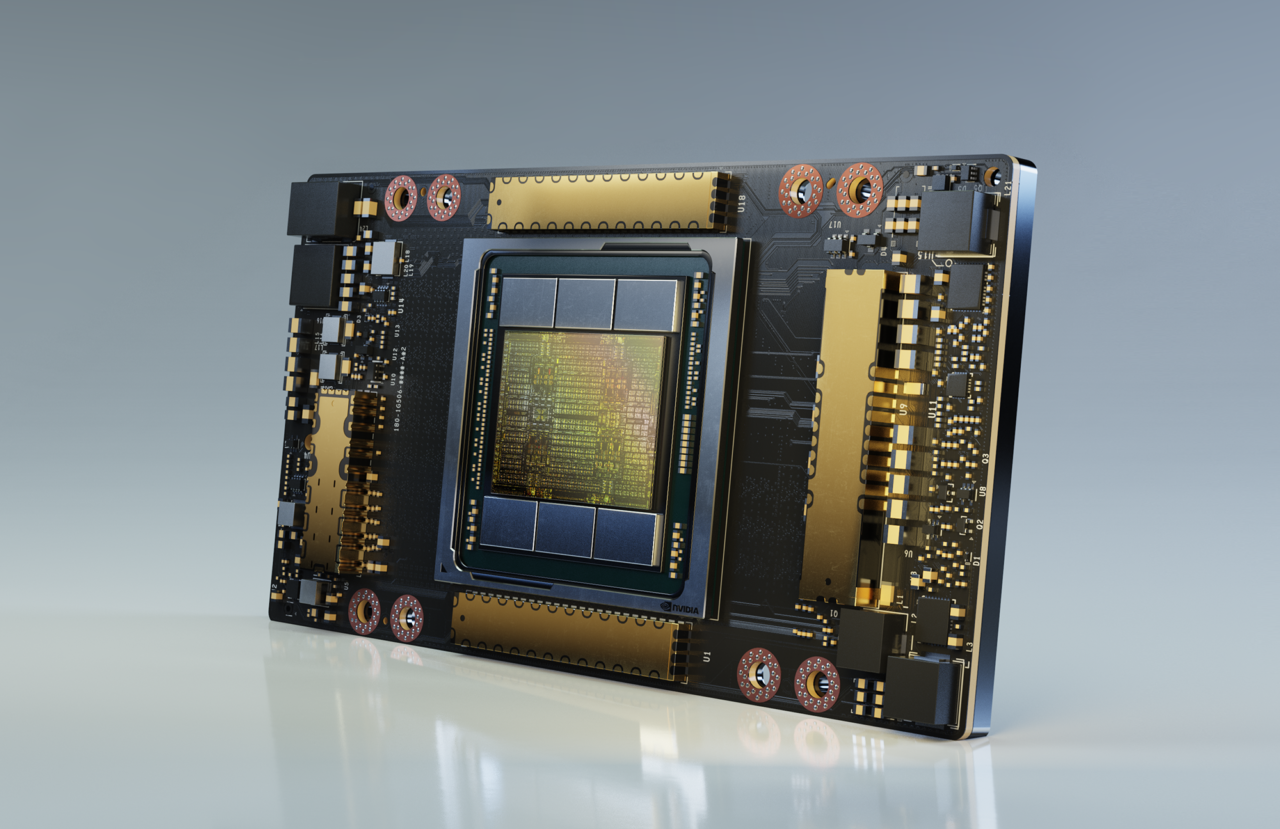

On peut notamment citer l’incontournable GPU A100. C’est une carte que vous ne retrouverez jamais dans un ordinateur grand public ; avec 80 GB de mémoire et 2 TB de bande passante pour un total de 312 TFLOPS et un coût d’environ 10 000 € par unité, elle est conçue pour être installée en série afin de traiter des ensembles de données monstrueux. De très nombreux supercalculateurs utilisent aujourd’hui des variantes de ce modèle sous architecture Ampere.

Une puce plus puissante que les A100 d’Nvidia

C’est là qu’intervient Google avec ses puces Tensor. Si le nom vous dit quelque chose, c’est que le concept ne date pas d’hier ; elles ont été présentées pour la première fois pendant le pic de la pandémie de Covid 19.

À l’époque, ce produit était présenté comme une puce spécialisée dans l’intelligence artificielle destinée aux smartphones Pixel. Mais depuis, Google semble avoir fait de gros progrès sur ce terrain. Dans un papier de recherche relayé par Reuters, la marque a présenté la quatrième génération de sa puce propriétaire Tensor Processing Unit (TPU) destinée non plus aux appareils mobiles, mais aux engins HPC.

Et la firme est très fière des performances de ses TPU. Elle avance que dans un système de taille équivalente, ces composants battraient même les A100 à plate couture. Le papier de recherche explique que ces puces proposent jusqu’à 70 % de puissance de calcul supplémentaire avec un rendement 90 % meilleur que les puces HPC d’Nvidia !

Cela ne signifie pas que Google a déjà dépassé son concurrent dans ce domaine. Le géant vert dispose encore d’une avance confortable. Car même si les A100 restent très populaires, elles ont été supplantées par le nouveau modèle H100. Ce dernier est six à sept fois plus puissant sur certains benchmarks. Il n’était pas encore disponible à l’époque où Google a réalisé son test comparatif. Mais si l’on se base sur les résultats obtenus, ces TPU semblent deux à trois fois moins performants que les Nvidia H100.

Mais apparemment, la filiale d’Alphabet ne veut pas s’arrêter là. Jouppi a déclaré à Reuters que l’entreprise avait monté « un pipeline de développement sain pour ses futures puces ». Cela sous-entend que Google travaille probablement déjà sur un nouveau modèle capable de boxer dans la même catégorie que les H100. Il faudra donc garder un œil sur l’avancée de ce projet.

Car la firme ne fait pas que travailler sur ses puces. Elle les met déjà à contribution dans un système qui progresse à grande vitesse. L’entreprise affirme que plus de 90 % de ses travaux d’entraînement de modèles IA sont réalisés grâce à ces TPU. C’est une information pas si anecdotique qu’elle en a l’air. Car il y a quelques années encore, il aurait été très difficile de travailler à cette échelle sans utiliser le matériel d’un mastodonte du secteur, comme NVIDIA, HP, Intel ou AMD.

Un supercalculateur IA qui progresse à vue d’oeil

Plus précisément, le papier explique que ces TPU sont déjà utilisés dans un supercalculateur IA entré en service en 2020. L’engin est actuellement doté de 4000 TPU reliés par fibre optique, et non pas par de simples câbles électriques.

C’est un autre point très important. Car plus le temps passe, plus la taille et la complexité des modèles augmentent. Pour les entraîner, il faut donc utiliser des unités de traitement puissantes, certes. Mais il faut aussi s’assurer qu’elles puissent communiquer correctement entre elles. Autrement, on provoque ce qu’on appelle un goulot d’étranglement, ou bottleneck, où un seul maillon faible ralentit l’ensemble du système. Utiliser l’optique plutôt que l’électronique est très intéressant à ce niveau. Cela permet d’augmenter la bande passante tout en préservant l’intégrité du signal.

Google insiste aussi sur l’architecture ; son supercalculateur semble plus ou moins modulaire. Et là encore, il s’agit d’un avantage déterminant par rapport aux engins traditionnels. Cette approche facilite et accélère grandement la résolution des problèmes techniques. Mais surtout, cela permet d’augmenter la puissance de calcul si nécessaire, et même d’adapter l’architecture à la volée pour qu’il fonctionne mieux avec un modèle en particulier.

« Cela facilite la recherche des composants défaillants », explique Norm Jouppi, ingénieur chez Google, dans un communiqué. « Cette flexibilité nous permet même de changer la topologie des connexions au sein du supercalculateur pour accélérer les performances d’un modèle précis », indique-t-il.

Plus le temps passe, plus Google se positionne comme un concurrent de premier plan en informatique haute performance. Et cette montée en puissance favorisée par l’explosion du machine learning pourrait aboutir à une redistribution significative des cartes dans le monde de l’HPC. Affaire à suivre !

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.

L’auteur n’ayant pas jugé pertinent de partager la publication de Google, je me permets de le faire :

https://arxiv.org/abs/2304.01433

À noter tout de même, le terme “papier de recherche” est à relativiser. Si ça y ressemble visuellement, le papier n’a apparemment été soumis à aucun journal.

Est ce que les chercheurs utilisent l’IA des processeur qu’ils construisent pour améliorer ses meme processeur?

Les processeurs n’étant pas “équipés” d’IA, la réponse est probablement “non”…