Depuis la sortie de ChatGPT, tous les grands noms de la tech n’ont plus qu’une idée en tête : proposer leur propre version du chatbot dopé au machine learning. Pour l’instant, ils se sont presque tous pris les pieds dans le tapis — et parfois de façon spectaculaire.

Amazon, de son côté, est resté plutôt discret sur ce terrain. Plutôt étonnant, sachant que la firme de Jeff Bezos n’est jamais bien loin lorsqu’il s’agit d’investir dans une technologie à fort potentiel. Mais cela ne signifie pas qu’elle ignore sciemment la révolution que nous voyons émerger en ce moment. Son PDG, Andy Jassy, a confirmé dans une interview au Financial Times qu’elle travaillait déjà sur des IA génératives depuis belle lurette.

Et cette semaine, nous avons effectivement vu émerger les prémices d’un nouveau modèle de langage signé Amazon. Dans un papier de recherche repéré par Futura, les chercheurs de la firme ont présenté un nouveau modèle IA aux performances impressionnantes.

Les modèles de langage ont du mal avec la logique de base

Les modèles de génération de langage les plus performants du moment, comme GPT-3.5 (celui qui alimente ChatGPT), utilisent une approche dite de « standard prompting ». Très vulgairement, cela signifie qu’ils tentent d’analyser la question dans sa globalité, en une seule étape.

Ils sont très performants lorsqu’il s’agit de réaliser des tâches qui peuvent être abordées facilement et intuitivement par les humains. En revanche, dès qu’il faut décomposer un raisonnement en plusieurs étapes, ces algorithmes ont tendance à perdre les pédales. Ils produisent alors des réponses sans queue ni tête que les spécialistes qualifient d’« hallucinations ».

On trouve un très bon exemple de cette distinction dans ce papier de recherche de Google. Les auteurs ont demandé à un modèle de langage de trouver la réponse au problème suivant. «Le personnel de la cafétéria dispose de 23 pommes. S’ils en utilisent 20 pour préparer le repas et qu’ils en achètent 6 de plus, combien de pommes ont-ils ? »

C’est un problème assez basique que tous les humains apprennent à résoudre dès l’école primaire ; il suffit de le décomposer et d’effectuer un petit calcul rapide pour déterminer qu’il reste neuf pommes.

Mais les systèmes qui utilisent le « standard prompting » se laissent souvent piéger dans ces cas de figure. Le modèle LaMDA testé par les chercheurs dans les travaux ci-dessus a par exemple conclu qu’il restait… 27 pommes, sans préciser comment il avait obtenu ce résultat.

Pour contourner ce problème, de nombreux chercheurs développent des systèmes basés sur une autre approche baptisée Chain of Prompt (CoT) prompting.

Le Chain of Thought, une approche très prometteuse

L’idée, c’est de permettre à un modèle de langage de déconstruire l’énoncé du problème pour procéder étape par étape, comme le ferait un humain.

Si l’on reprend l’exemple ci-dessus, avec cette approche CoT, l’algorithme ne se contente plus d’affirmer directement que « La réponse est 27 ». À la place, il commence par reformuler l’énoncé. « La cafétéria avait 23 pommes à l’origine. Ils en ont utilisé 20. Donc ils en avaient 23 – 20 = 3. Ils ont acheté 6 pommes supplémentaires, donc ils en ont 3 + 6 = 9. La réponse est 9 ».

En découpant ainsi le problème, l’algorithme fournit donc une réponse beaucoup plus élaborée — et surtout correcte. Il s’agit ici d’un exemple appliqué aux maths, mais cette approche est aussi valable pour tous les autres cas de figure traités par ces algorithmes.

De nombreux chercheurs s’attendent donc à ce que les modèles de langage de type GPT-3 incorporent tous cette approche Chain of Thought dans un futur proche. Dans l’idéal, cela permettra de diminuer considérablement le nombre d’hallucinations.

Amazon a poussé ce concept encore plus loin. Grâce à une nouvelle approche multimodale (ils parlent de Multimodal-CoT), son nouveau modèle est capable de “comprendre” du texte, mais aussi des images, ou une combinaison des deux.

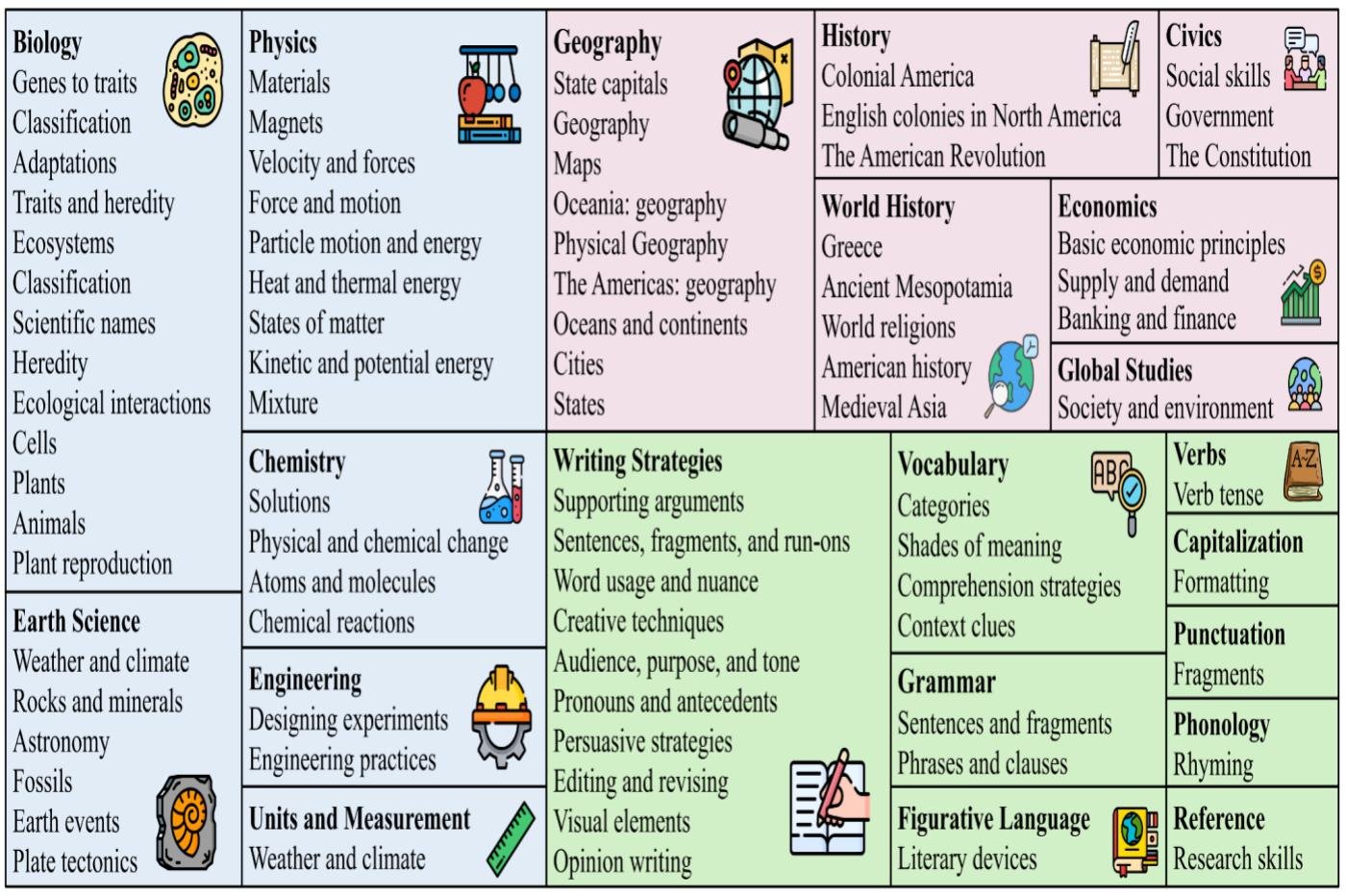

Ils l’ont testé et mis à l’épreuve sur un test baptisé ScienceQA. C’est un ensemble de 21 280 questions scientifiques à choix multiples sur des sujets divers et variés qui sert de benchmarks pour les modèles de langage. Les énoncés reposent à la fois sur du texte et des images. Il s’agit donc d’un véritable instrument de torture pour les IA qui utilisent l’approche du standard prompting.

Le nouveau modèle d’Amazon fait mieux que GPT-3.5

GPT-3.5, la référence du genre, a par exemple obtenu un score de 73,97 %. C’est honorable, mais encore très loin du score de référence humain (un peu plus de 88%). Le nouveau modèle d’Amazon qui utilise l’approche Multimodal-CoT, en revanche, a signé un impressionnant 91,68 % ! Cela signifie que dans l’ensemble, il a très bien compris les énoncés, a su les décortiquer pour proposer des réponses correctes avec très peu d’hallucinations.

Le résultat est déjà impressionnant dans l’absolu, mais il y a un autre élément qui lui donne encore plus de valeur : le nombre de paramètres du modèle. En règle générale, la “puissance” de ces algorithmes dépend largement de cette métrique. Pourtant, le modèle d’Amazon repose sur un nombre de paramètres assez limité : 738 millions, contre 175 milliards pour GPT-3.5 ! Au-delà des performances brutes, c’est donc aussi un franc succès en termes d’optimisation.

Reste à voir comment cette IA fonctionnera hors du cadre d’un QCM, avec des questions ouvertes comme celles qu’on peut poser à ChatGPT. C’est évidemment beaucoup plus compliqué. Mais ces résultats montrent à quel point la piste des modèles Chain of Thought est prometteuse. Il sera donc intéressant de voir si les entreprises qui développent des modèles de langage vont miser dessus. On pense notamment à Microsoft et Google, dont les programmes Bard et Bing AI ont enchaîné les erreurs grossières ces derniers temps…

Le texte de l’étude est disponible ici. Le code du modèle est disponible en accès libre sur GitHub.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.

Chat GPT n’arrête pas de se tromper, c’est sans arrêt.et son politiquement correct finit par être insupportable en plus de le conduire à tout un tas de contradictions

“réponses sans queue ni tête que les spécialistes qualifient d’« hallucinations »”… en IA toute réponse est une hallucination, et non les réponses erronées uniquement. Que ce soit pour créer une image ou donner une réponse écrite. C’est le principe même de la génération de leurs résultats : entrainés à générer des hallucinations