Ces derniers mois, même les non initiés ont pu prendre conscience des progrès fulgurants de l’intelligence artificielle à travers des outils novateurs. Internet est notamment tombé amoureux des outils génératifs ; avec leur capacité à produire des images bluffantes ou des morceaux de texte plus vrais que nature, entre autres, ils sont aussi impressionnants que divertissants. Et tout récemment, ce sont les troupes d’OpenAI ont encore étendu cet éventail de possibilités déjà faramineux ; les concepteurs de DALLE-E, le pionnier de la génération d’image qui a fait des tas d’émules, s’attaquent désormais aux objets 3 D.

Comme DALL-E, leur nouvelle création baptisée Point-E réagit à une simple description textuelle écrite en langage courant. La différence, c’est qu’il ne propose pas une image en retour, mais plutôt un objet 3D constitué d’un nuage de points.

Les meshes 3D, des objets complexes

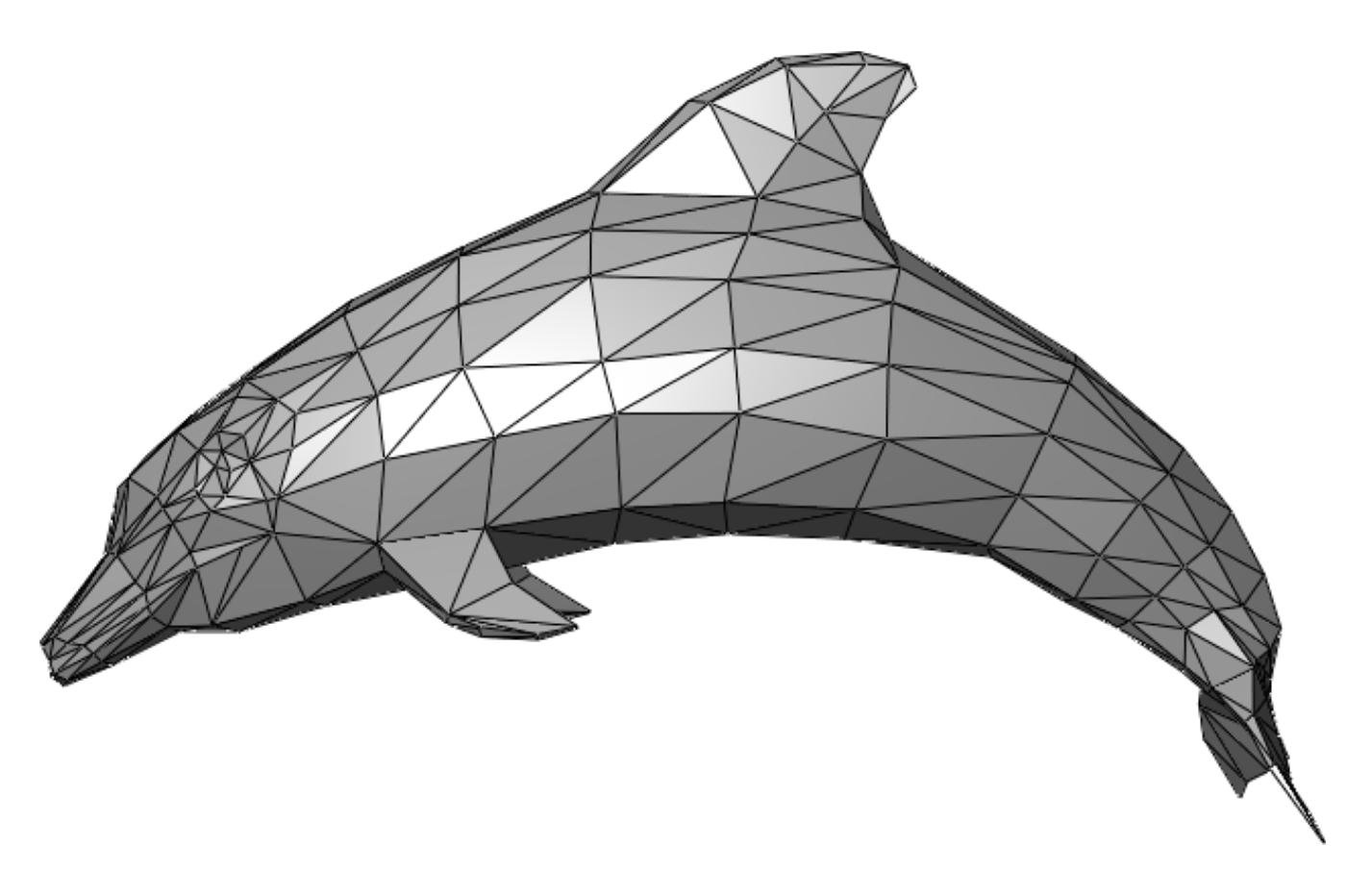

Dans vos jeux vidéo et films d’animation préférés, les modèles 3D qui constituent l’environnement, les personnages, et la grande majorité des objets solides du décor sont construits à partir d’un maillage (mesh) de sommets (vertex, ou vertices au pluriel). Ils peuvent être reliés pour définir des bords (edges) qui délimitent ensuite des faces. Ce sont ces dernières qui sont colorées à l’aide de différentes textures et effets de lumière pour donner son apparence finale au modèle.

Un objet 3D est souvent constitué d’un grand nombre de sommets. Même les plus rudimentaires, comme le dauphin ci-dessous, en comptent souvent quelques centaines ; dans certains cas, des modèles détaillés peuvent dépasser allègrement le million de points pour. Grâce aux prouesses techniques d’Epic Games avec la technologie Nanite qui équipe Unreal Engine 5, on se dirige même vers l’implémentation de modèles à plusieurs milliards de points dans un moteur en temps réel.

C’était inconcevable auparavant, car l’ordinateur doit gérer tous ces éléments individuellement. Pour un modèle très détaillé, il doit recalculer en permanence la position de chaque point, la couleur de chaque face par rapport à sa texture et aux différentes sources de lumière… c’est en partie pour cette raison qu’un superbe jeu comme le récent God of War : Ragnarök a besoin d’une machine puissante pour tourner dans de bonnes conditions.

Et ce problème ne concerne pas que les game artists. C’est aussi un gros problème pour les chercheurs en IA. Car générer des objets de ce genre automatiquement est une tâche immensément complexe en termes de calcul. Même pour des IA spécialisées ne font pas de miracles à ce niveau. La recherche sur la génération de modèles 3D avait donc tendance à progresser assez lentement. Les algorithmes de ce genre restent effroyablement lents, en plus de proposer des résultats de piètre qualité par rapport à un artiste humain.

Deux intermédiaires pour un algorithme fulgurant

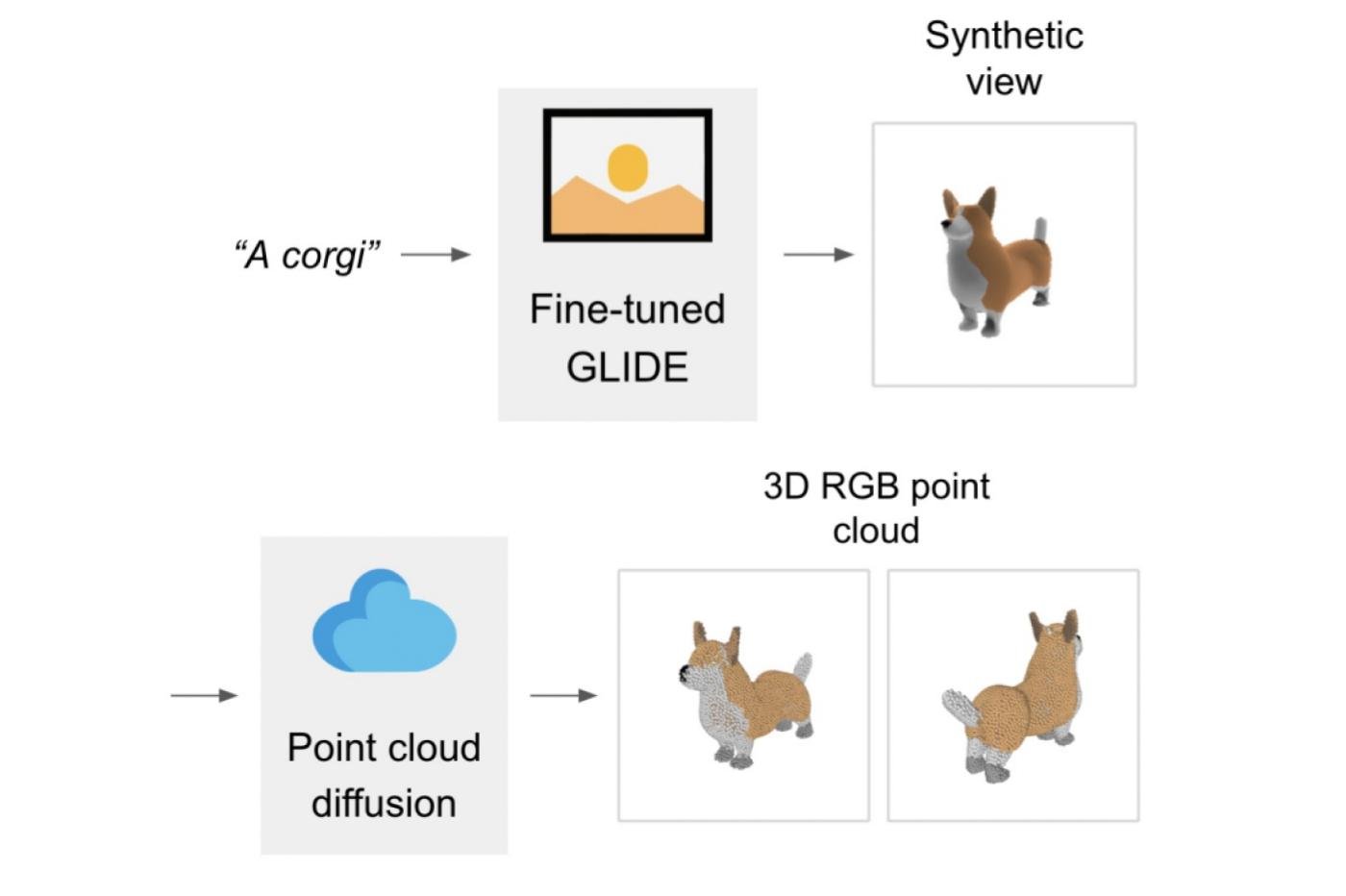

Pour contourner cette limite, les chercheurs d’OpenAI ont exploré une autre approche. Tout commence avec un premier algorithme dit « text-to-image ». Le concept est exactement le même que celui de DALL-E et consorts ; une fois entraînée, il suffit de lui fournir une description textuelle, et le programme recrache une image correspondante.

Mais ici, dans ce cas, il ne s’agit pas de produire une œuvre d’art ; l’objectif est de proposer une image assez rudimentaire, puis de s’en servir comme intermédiaire pour alimenter un second sous-système.

Une fois le proxy généré, il est ingurgité par un autre algorithme. Celui-ci se charge de convertir l’image en trois dimensions. Pour l’entraîner, les chercheurs lui ont simplement fourni des couples d’images et de modèles 3D correspondants. Il a ainsi pu apprendre à faire le lien entre les deux formats.

La subtilité, c’est qu’il ne s’agit pas encore du produit fini ; c’est en fait un second intermédiaire. Car au lieu de cracher immédiatement un modèle 3D standard à base de sommets, d’arêtes et de faces, Point-E commence par produire un simple nuage de points.

Contrairement aux sommets d’un mesh classique, ces unités n’ont aucune relation fonctionnelle les unes avec les autres. Pour un ordinateur, il est nettement plus facile — et donc plus rapide — de décrire une forme en trois dimensions avec un nuage de point de ce genre. À partir de là, il reste donc une dernière étape : convertir ce nuage de points en un véritable maillage. C’est l’étape la plus facile, car il existe déjà des algorithmes performants capables de réaliser cette tâche.

Puisqu’il est basé sur deux proxy qui sont par définition approximatifs, l’objet produit ne sera pas particulièrement précis et réaliste. En revanche, l’ensemble du processus est extrêmement rapide. En introduisant ces étapes intermédiaires au lieu de foncer tête baissée vers le résultat final, les chercheurs ont obtenu un gain de vitesse ahurissant.

Selon eux, Point-E est plus rapide que les meilleurs générateurs 3D du moment. Et par plusieurs ordres de grandeur.“Notre méthode fonctionne moins bien que les techniques de pointe en termes de réalisme, mais elle produit des échantillons en une fraction de ce temps”, expliquent les auteurs de ces travaux.

Un potentiel pratique encore plus important que la génération d’images

Et c’est tout sauf négligeable. Car si l’on raisonne à l’échelle globale, il y a finalement assez peu d’applications qui nécessitent des modèles 3D ultra-détaillés. Ils sont très utiles dans la publicité et les produits de divertissement “haut de gamme”. On pense notamment aux gros blockbusters hollywoodiens ou les jeux vidéo AAA. Mais pour tout le reste, des modèles de moindre qualité peuvent souvent faire l’affaire. Et dans ces cas, un outil comme Point-E pourrait représenter une vraie révolution en termes de productivité.

Pour trouver un exemple simple, on peut imaginez le cas d’un développeur indépendant. Mettons qu’il souhaite développer une application mobile, comme un jeu de gestion sur le thème de la ferme. Pour donner corps aux animaux qui feront partie intégrante de son programme, il a plusieurs options à disposition.

La première, c’est d’apprendre les rudiments de la modélisation 3D. Il pourrait ainsi tout créer lui-même ; mais c’est un processus très long qui ralentira forcément le développement. Il peut aussi engager un artiste pour les réaliser à sa place. Mais cela coûte évidemment de l’argent.

Ou alors, il pourrait tout simplement souscrire à un service basé sur un algorithme de type Point-E. Il suffirait alors de lui réclamer successivement “une chèvre”, “un mouton” ou “une poule” pour générer tout son bestiaire en un clin d’œil. Et pourquoi s’arrêter en si bon chemin : tant qu’à faire, il pourrait aussi lui commander des modèles de légumes, de bâtiments…

Ce n’est qu’un exemple isolé et assez réducteur qui ne suffit pas à décrire les capacités de cette technologie. Mais elle permet au moins d’illustrer son potentiel énorme. Car il ne s’agit que d’un début.

Vers la maturation, puis la révolution ?

En effet, l’informatique généraliste et les algorithmes de machine learning progressent aujourd’hui très rapidement. On peut donc s’attendre à ce que ces programmes avancent eux-aussi bien plus rapidement qu’auparavant. Un peu comme les générateurs d’images et de texte. Pour rappel, ces derniers ont plus ou moins stagné pendant des années avant de connaître une explosion spectaculaire.

Mais le cas échéant, il s’agit peut-être d’une avancée peut-être encore plus importante. Car en définitive, même s’ils sont fascinants, en pratique, les applications des générateurs d’images sont encore assez limitées à cause des nombreux débats sur la propriété intellectuelle qui font rage en ce moment. Par contre, un système qui permettrait à n’importe qui de produire des modèles 3D à la volée pourrait éventuellement être utilisé de façon très concrète dans des tas de contextes où ce problème de copyright est moins perceptible.

Imaginez seulement qu’un programme de type Point-E parvienne à produire des modèles 3D de calibre AAA à partir d’un simple concept art issu du studio en lui-même. Il s’agirait d’une véritable révolution dans le monde du jeu vidéo. Et pour cause : ces travaux de modélisation sont exceptionnellement chronophages. En faisant sauter cette contrainte, des petits poucets pourraient atteindre un niveau de qualité comparable à celui des titans du secteur. En parallèle, ces derniers pourraient augmenter significativement le rythme de production.

Et cela va encore plus loin. Car pour l’instant, il ne s’agit que de modélisation 3D. Mais sur le principe, cette approche est également applicable à d’autres disciplines. Dans un premier temps, cette approche pourrait être étendue à l’animation ou même au développement en lui-même. Et à terme, on peut même imaginer des autres industries comme l’architecture, l’ingénierie structurale… et même la génération d’images statiques comme celles des générateurs de type DALLE-E !

Il conviendra donc de prêter une attention toute particulière à l’évolution de ces technologies. Car OpenAI n’est évidemment pas la seule société à travailler là-dessus. On peut aussi citer le DreamFusion de Google, et d’autres grands noms vont sans aucun doute s’y intéresser à l’avenir. Et c’est typiquement le genre de concurrence qui pourrait faire exploser cette technologie, avec des implications profondes pour de nombreuses industries une fois arrivée à maturité.

Le papier de recherche est disponible ici. Voir aussi le repository GitHub.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.

« les applications des générateurs d’images sont encore assez limitées ». Générer gratuitement une image de qualité professionnelle avec le rendu souhaité que ce soit réaliste, 3D, abstrait, avec un motif répété, etc. Limité ? Les illustrateurs du monde entier craignent ces générateurs qui remplacent aisément le travail de centaines de milliers de professionnels. Dans la pub, les concept arts, sur les vêtements, les motifs de tapisseries, les posters. Etc. Sans avoir à faire quoi que ce soit derrière.

Vos hypothétiques utilisations de Point-E se limitent aux jeux vidéos et au cinéma, et se basent juste sur une hypothèse d’amélioration qui va au delà des ambitions des créateurs eux-mêmes. Ces rendus nécessiteraient dans tous les cas du travail de retouche d’un pro, mais ne remplaceront pas entièrement le boulot d’un pro comme le fait Midjourney.

Un nuage de points, c’est une bonne base pour de la modélisation, mais ça n’a rien à voir et c’est beaucoup plus limité qu’un jpg généré sur demande. Cet article fumeux m’écœure, et le pire c’est que je suis sûr que vous recherchez ce genre de réaction de la part des lecteurs pour faire du clic.

Bonjour,

Vous n’avez surtout pas lu l’article jusqu’au bout.

Le nuage de point n’est qu’une phase intermédiaire.

Au final un mesh est généré.

Je ne sais pas s’il est déjà texturé mais rien que le mesh ça m’éviterait de passer des heures sur Blender, les yeux plissés.

Les développeurs indépendants pourraient se focaliser sur les mécanismes de jeu et gagner ainsi un temps considérable.

Cordialement,

Lyzbeth d’Andrésy.

Ce qui est valable pour les conversations, la 2D, la 3D ou la musique peut l’être pour tout ce qui touche à l’informatique.

Open IA nous laisse entrevoir là la future révolution qui va impacter le monde.