L’annonce la plus importante concerne une plateforme dévoilée en mai dernier : le Multitask Unified Model (ou MUM) vient désormais se greffer à l’écosystème Google. Cette plateforme présentée ce printemps à l’I/O permet d’extraire des informations à partir d’un large panel de formats texte, vidéo, ou audio. Elle se charge ensuite d’identifier les liens entre les différents concepts pour fournir des informations plus pertinentes.

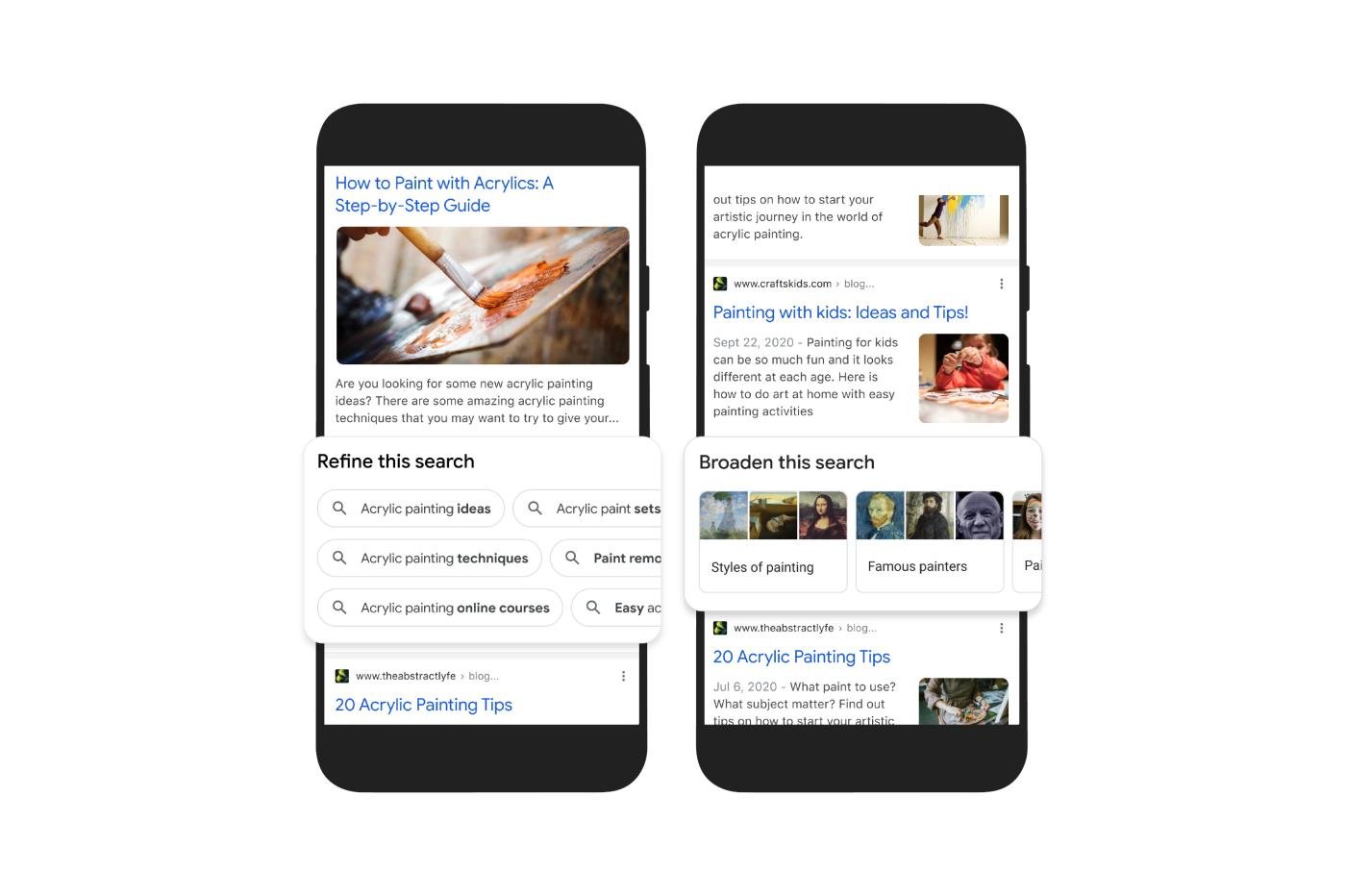

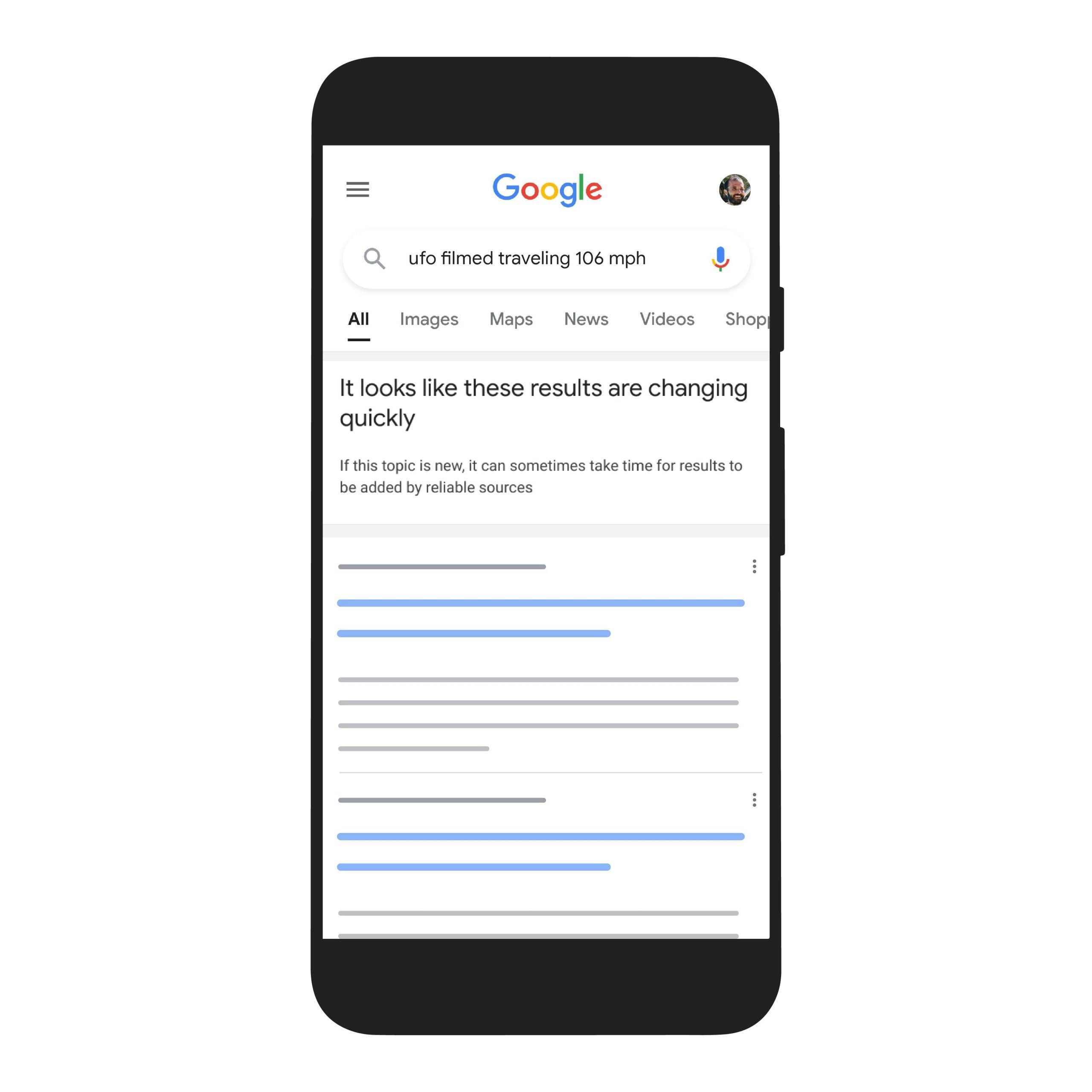

Cette technologie viendra bientôt prêter main-forte à Google Search afin de proposer des pistes plus intuitives pour s’orienter dans ses recherches. Le moteur disposera bientôt de deux sections “affiner la recherche” et “étendre la recherche”. Il se dotera aussi d’un nouveau mode d’affichage basé sur l’image, pour “parcourir visuellement” les résultats d’une recherche Google. MUM se chargera également de décortiquer les vidéos pour vous. Google parle d’une nouvelle fonction qui “identifie les sujets en rapport avec une vidéo, même s’il n’est pas mentionné explicitement”.

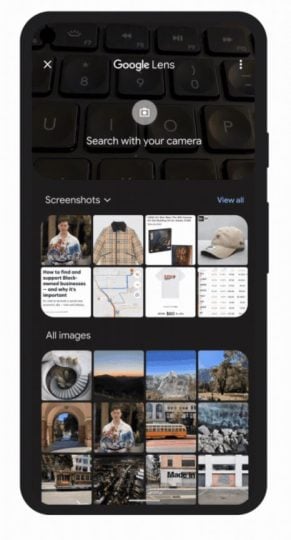

Ce système viendra également doper Google Lens avec de “toutes nouvelles fonctions de recherche”. Nous pourrons par exemple ajouter du texte aux recherches par image, et même formuler des questions sur les résultats proposés. “Si vous voyez un t-shirt qui vous plaît, mais que vous auriez préféré ce motif sur vos chaussettes, il suffira de pointer sa caméra dessus et de poser la question”, explique ainsi l’équipe de Google. Au passage, Google Lens s’invitera aussi sur la version desktop de Google Chrome. Il sera possible d’utiliser cet outil sur n’importe quel texte, image, vidéo pour obtenir tout un tas d’informations complémentaires sans quitter la page.

Ces fonctionnalités seront déployées dans les mois à venir en langue anglaise, avant d’être traduites à une date encore inconnue.

Des sources plus claires

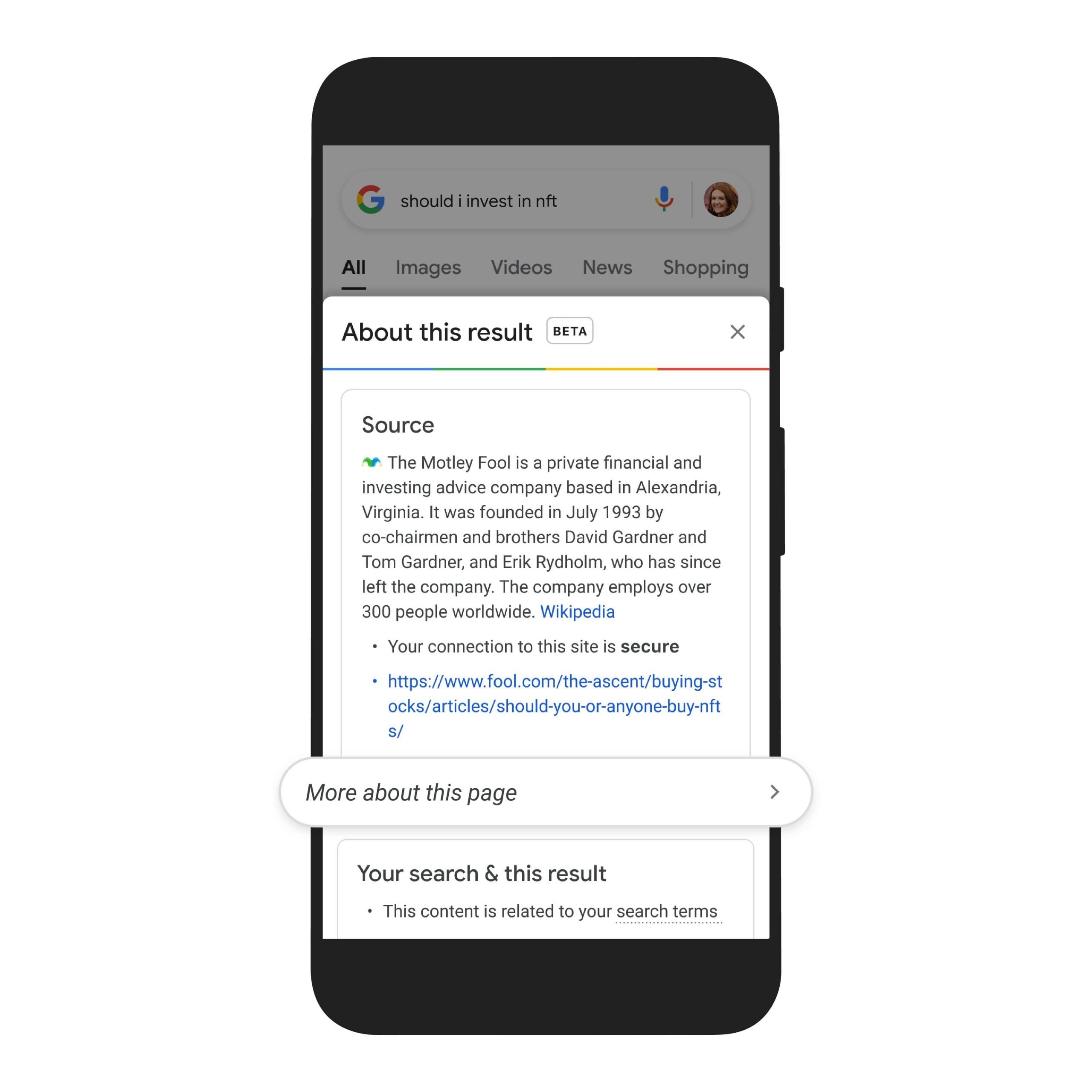

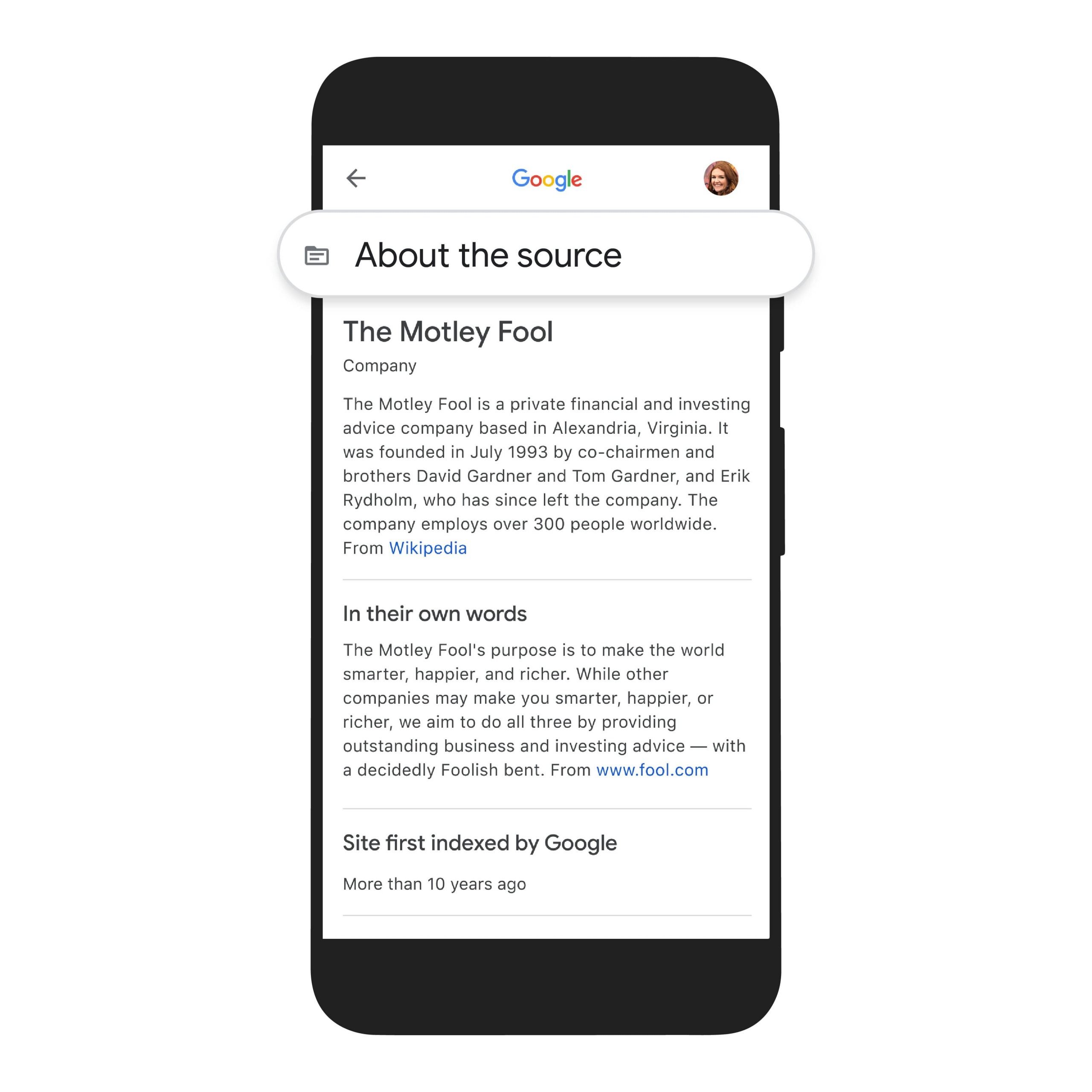

La fonctionnalité “À propos de ce résultat” va également s’étoffer. Aujourd’hui, cette fonctionnalité permet déjà de se renseigner sur la source d’un résultat grâce à un article Wikipedia sur l’auteur. Bientôt, cet encart comprendra également une section qui synthétise des informations externes (articles de presse, avis d’internautes…) à propos de cette source, pour pouvoir situer l’information dans son contexte. Cette section s’enrichira également de résultats issus d’autres sources sur le même sujet. L’objectif reste le même : avoir une meilleure vue d’ensemble sur la question abordée.

Cette fonctionnalité est pour l’instant réservée aux États-Unis, mais devrait ensuite arriver en Europe.

L’e-shopping en temps réel

Google veut également améliorer l’expérience e-commerce de ses utilisateurs avec Google Shopping Graph. Il s’agit d’une immense base de données de produits, d’inventaires et d’e-commerçants, avec plus de 24 milliards de références. Elle permettra d’obtenir des résultats plus pertinents au moment de trouver sa prochaine console, tenue, ou bicyclette.

Les inventaires de nombreux marchands seront mis à jour en temps réel. Cela évitera de perdre du temps à consulter des listings pour se rendre compte au dernier moment qu’il ne sera pas en stock avant plusieurs semaines. Cela vaut pour les boutiques en ligne, mais aussi pour vos échoppes physiques préférées. En revanche, Google n’explique pas comment ce listing est mis à jour ni quelles enseignes sont concernées ou non. Mais nous devrions être fixés très vite puisque la fonctionnalité débarque dès aujourd’hui en France.

L’essor du “big data” en temps réel

Enfin, Google annonce également deux nouveautés du côté de son service de cartographie. L’été dernier, nous vous parlions d’un nouveau système qui permettait de consulter le périmètre des incendies en cours sur Google Maps. Désormais, ces événements auront droit à leur propre couche dédiée sur Google Maps. Pour chaque incendie, il sera bien s^pur toujours possible de consulter en direct le périmètre. Mais en plus, les internautes pourront avoir accès à des informations comme les numéros des services d’urgence locaux, ou la surface brûlée.

Nous vous présentions aussi Tree Canopy Lab, un outil qui veut aider les villes à se végétaliser de façon efficace. Le système a été testé à Los Angeles cet été; il est désormais étendu à plus de 100 villes majeures dans différents pays. Les municipalités des plus grandes mégalopoles auront donc bientôt accès à cet outil permettant d’optimiser la couverture végétale en zone urbaine.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.