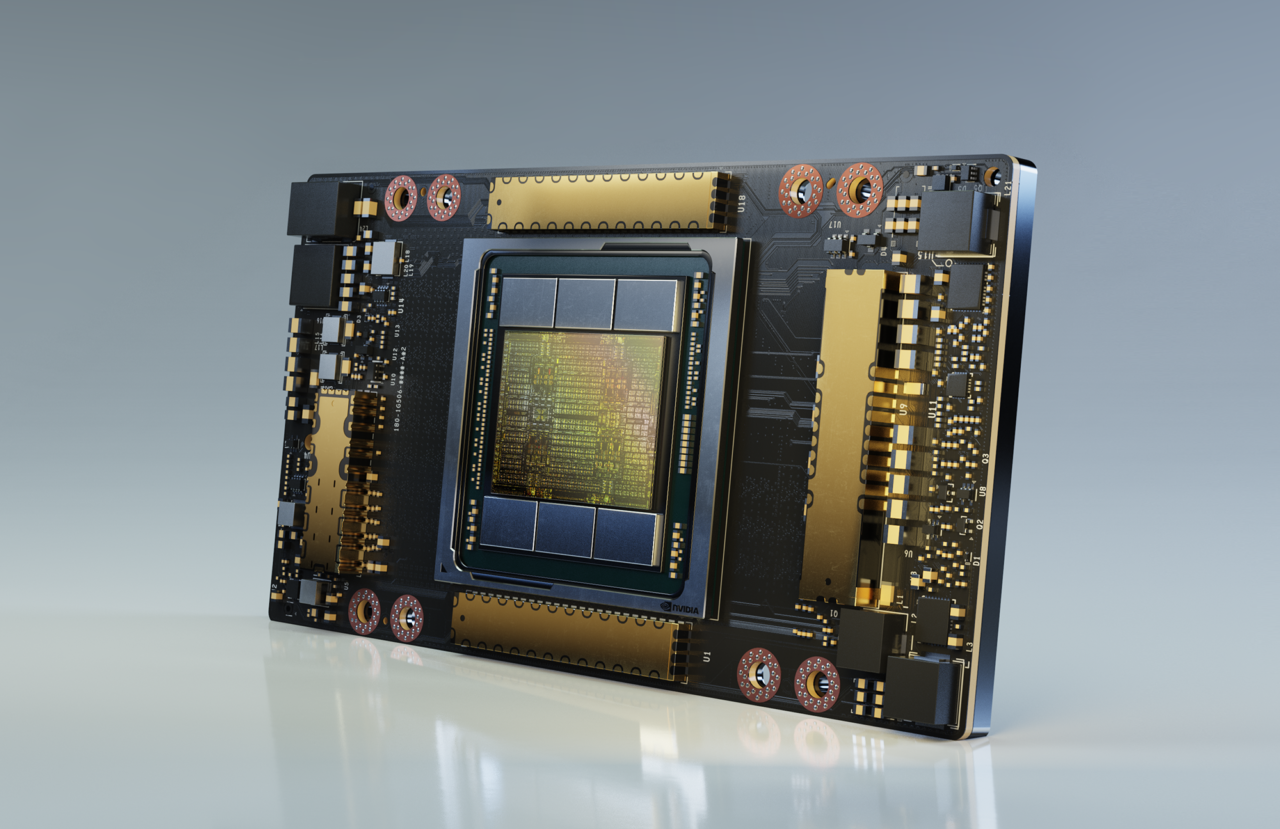

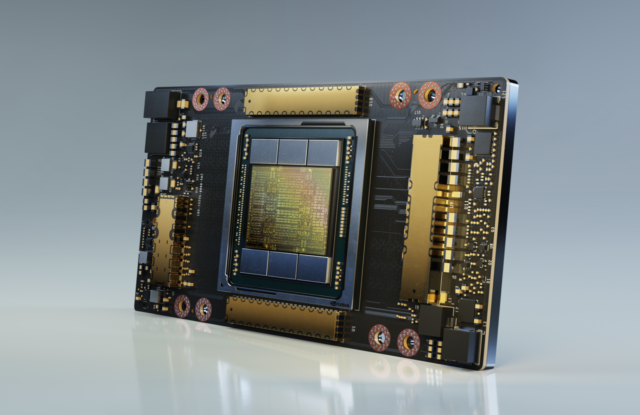

Nvidia a levé le voile sur l’A100, le premier GPU basé sur l’architecture Ampere, qui contient 54 milliards de transistors 7 nm. Cette carte, destinée au marché des serveurs, accélère jusqu’à 20 fois (par rapport aux précédents modèles) la simulation de l’intelligence artificielle et de l’inférence, des opérations de déduction à partir d’informations implicites. Les GPU sont connectés entre eux par la troisième génération du Nvidia NVlink, qui double la connectivité à haut débit.

De la puissance pour les calculs d’IA

Si tout cela est un peu obscur, plusieurs clients de Nvidia qui utilisent déjà l’A100 permettent de se faire une idée des capacités de ce GPU. Chez DoorDash, le service de livraison de repas, l’A100 réduit le temps de formation des modèles (sur lesquels s’appuient les fonctions IA) et accélère le processus de développement de l’apprentissage automatique. L’université de l’Indiana se servira du GPU pour soutenir la recherche scientifique et médicale et la recherche avancée en IA et analyse de données.

L’Institut Technologique de Karlsruhe, en Allemagne, pourra réaliser des simulations multi-échelles beaucoup plus importantes dans le domaine des sciences des matériaux, des sciences du système terrestre, de l’ingénierie pour la recherche sur l’énergie et la mobilité. Bref, les usages pour un tel GPU ne manquent pas. L’A100 va être intégrés dans les systèmes de plusieurs constructeurs de serveurs, dont Atos, Cisco, Dell, Inspur, Lenovo, Supermicro, etc.

Nvidia a également annoncé le DGX A100, troisième génération du système d’intelligence artificielle du constructeur qui offre 5 pétaflops de performances dans le domaine de l’IA et de l’apprentissage automatique. Ces systèmes embarquent huit Sensor Core A100. Des unités sont déjà en service, notamment pour exécuter des modèles et des simulations pour lutter contre la COVID-19.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités. Et si vous nous adorez, on a une newsletter tous les matins.